Você já se perguntou como alguns sites sempre aparecem no topo dos resultados de pesquisa do Google enquanto outros ficam perdidos nas páginas seguintes? Quer entender por que isso acontece?

A resposta é: Técnicas de SEO (Search Engine Optimization), uma arte e ciência estratégica de otimização do seu site para ser amigável aos mecanismos de busca. Ao adotar uma estratégia de SEO eficaz, você não apenas melhora o posicionamento do seu site nas páginas de resultados naturais (orgânicos), mas também atrai mais visitantes e aumenta suas chances de conversão.

Mas o que exatamente é SEO? E por que ele se tornou essencial para o marketing digital?

Neste guia definitivo sobre o assunto, você saberá mais sobre essa prática essencial, que tem o poder não apenas de aumentar a visibilidade do seu site, mas também de transformar visitantes casuais em clientes fiéis.

Além disso, você aprenderá a mestria da pesquisa de palavras-chave, a fundação de qualquer estratégia de SEO bem-sucedida. E não para por aí; também abordaremos as melhores práticas de link building, uma técnica de SEO essencial para fortalecer a autoridade do seu site aos olhos dos mecanismos de busca.

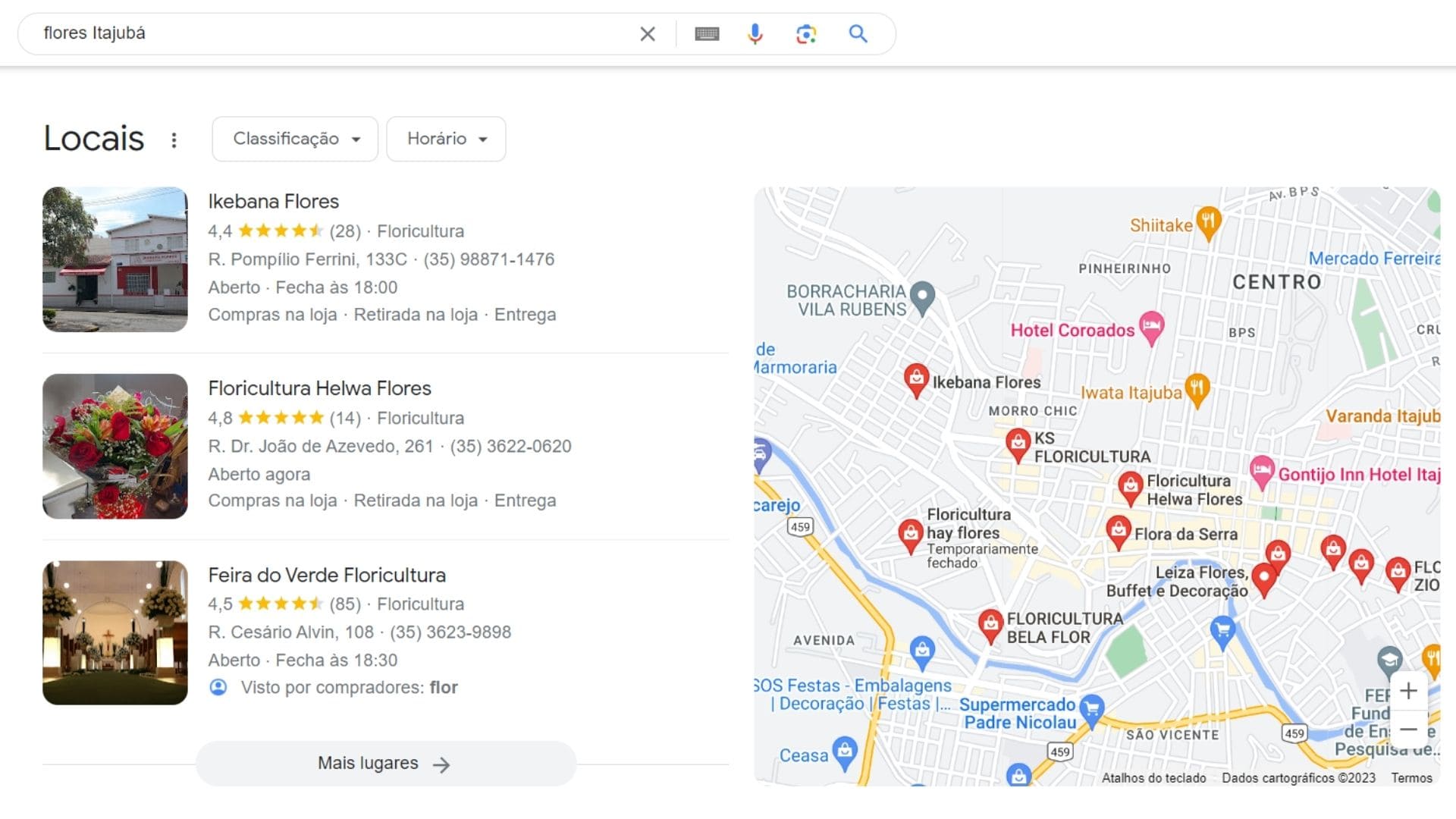

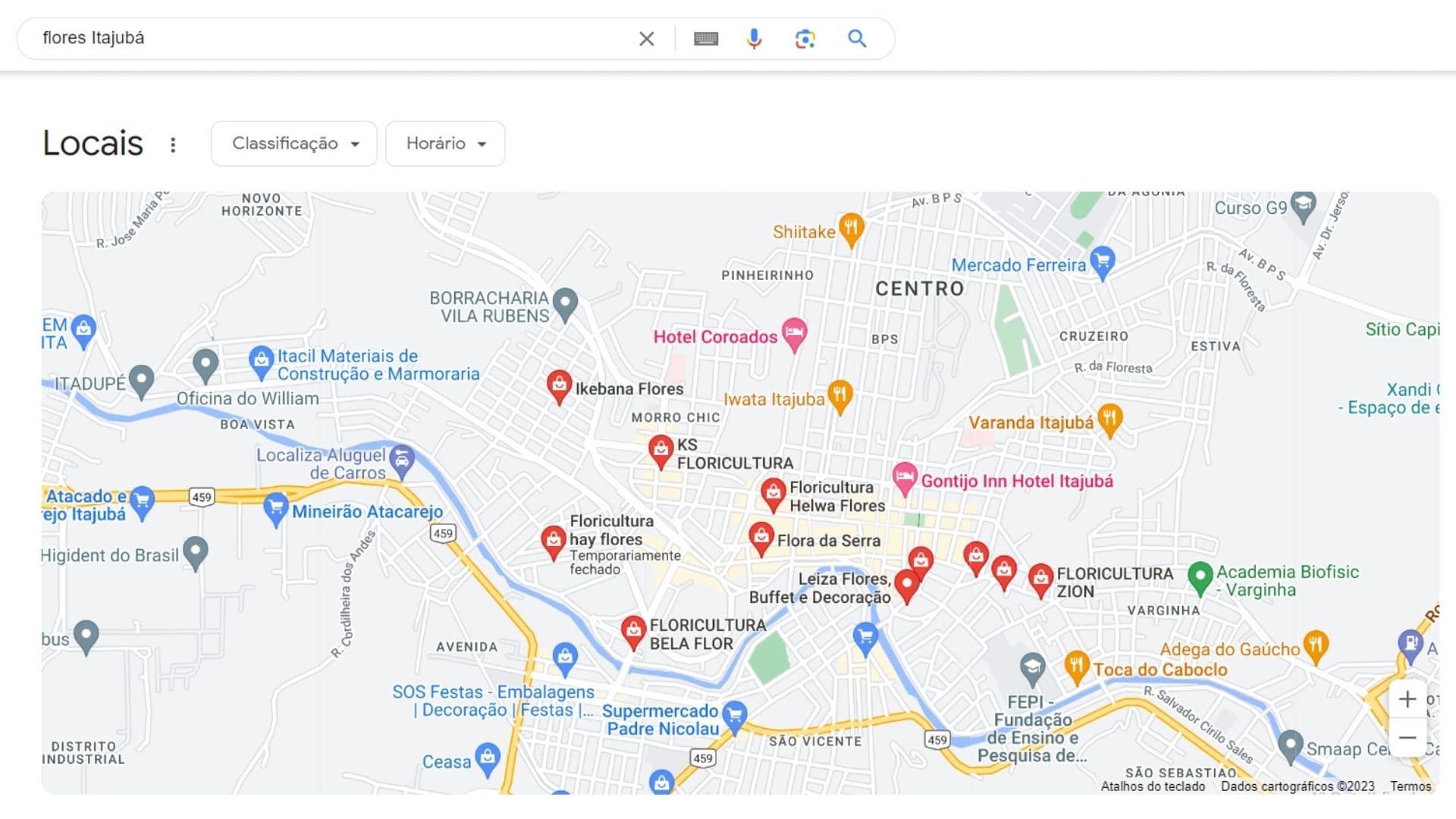

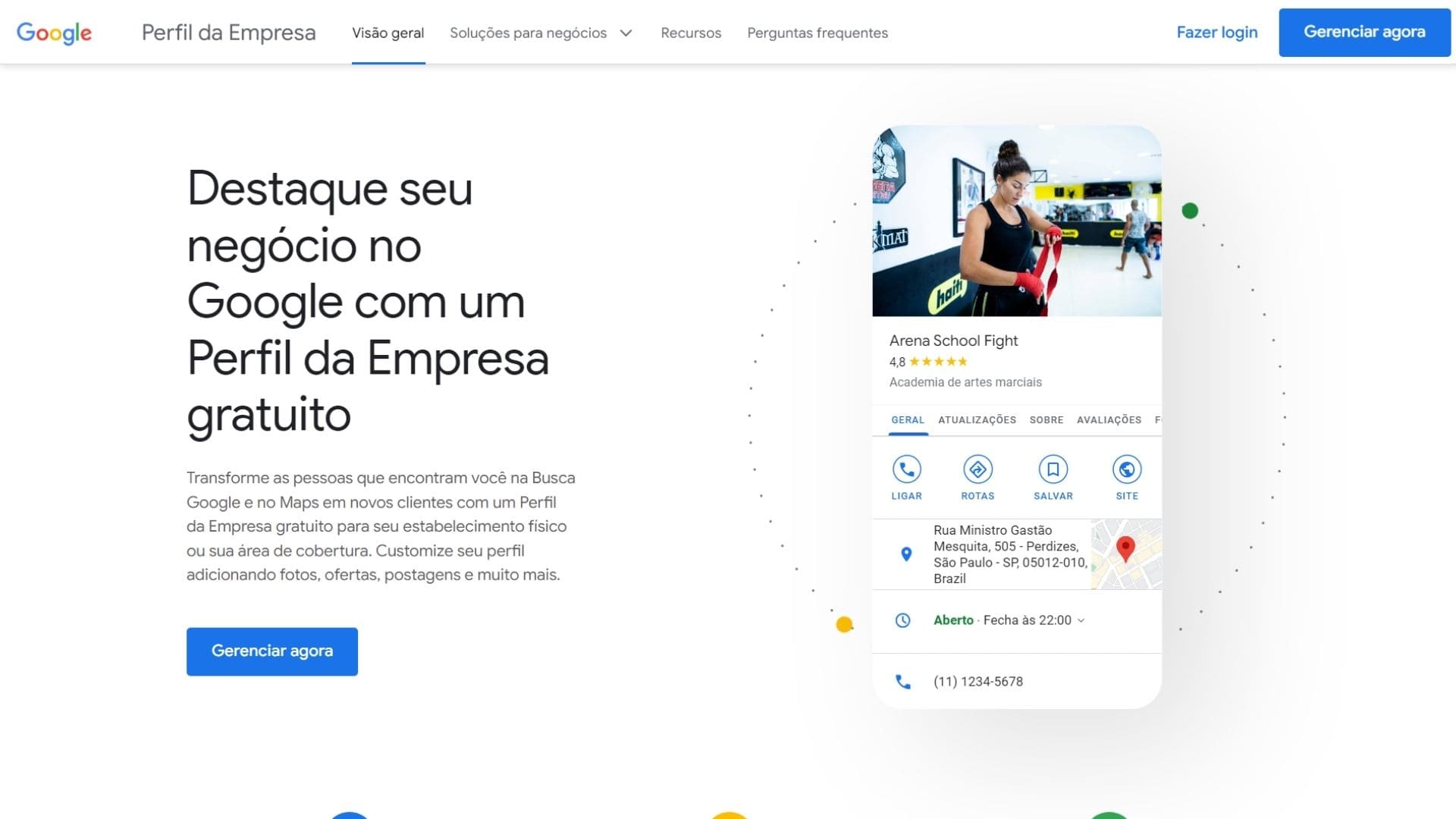

Quer mais? Vamos mergulhar na busca local e mostrar como otimizar seu site para atrair clientes da sua região, uma estratégia frequentemente ignorada, mas incrivelmente eficaz. Ao final deste guia, você terá em mãos um roteiro completo para transformar o seu site em uma máquina de geração de tráfego e conversões.

Então, se você está se perguntando como fazer seu conteúdo brilhar na imensidão da web, ou simplesmente busca entender melhor essa ferramenta poderosa, continue a leitura deste artigo para conferir:

- O que é SEO? Entendendo o Search Engine Optimization (SEO);

- Qual a Vantagem do SEO?;

- Técnicas de SEO: Fatores On-Page;

- Técnicas de SEO: Fatores Off-Page ou Externos;

- Técnicas de SEO: Link Building;

- O que é Black Hat SEO?: Técnicas de SEO para você evitar;

- Otimizações de SEO: Cuidados com Punições e Filtros;

- Técnicas de SEO: Local Search SEO;

- Consultoria de SEO.

O que é SEO?

A sigla, que vem se tornando cada vez mais popular, se refere ao termo em Inglês “Search Engine Optimization”, mas você sabe o que significa SEO?

SEO, então, é um conjunto de estratégias digitais que visa melhorar a visibilidade e o posicionamento de páginas de um site nos resultados orgânicos (não pagos) dos motores de busca, como Google, Bing, e Yahoo.

Entendendo o Search Engine Optimization

Search Engine Optimization (SEO), é um conjunto de técnicas, métodos e/ou estudos que visam melhorar o posicionamento de suas páginas no mecanismo de busca. Em português, o termo Search Engine Optimization é traduzido como “otimização para mecanismos de busca”, ou seja, formas de tornar o seu site mais “importante” para aparecer nos resultados de pesquisa:

Basicamente, quando um usuário digita no mecanismo de busca uma palavra-chave, o objetivo do SEO é fazer com que uma (ou várias) das páginas do seu website, apareça entre os primeiros resultados da busca orgânica.

Seu objetivo é atrair tráfego qualificado para o site, aumentando assim as chances de conversão, seja em vendas, inscrições, downloads ou qualquer outra ação desejada pelo proprietário do site. Sendo assim, o SEO permite que empresas e criadores de conteúdo alcancem uma audiência maior de forma orgânica, sem a necessidade de pagar por anúncios.

Além disso, as vantagens do SEO também se refletem nos sites que, quando bem otimizados, tendem a:

- carregar mais rápido;

- melhorar a credibilidade e a confiança na marca;

- oferecer uma melhor experiência ao usuário;

- aumentar o alcance de mercado;

- ter taxas de conversão mais altas

O que faz um profissional de SEO?

Um profissional de SEO eficaz precisa ter uma combinação de habilidades técnicas, criativas e analíticas. Entre suas tarefas estão:

- pesquisa de palavras-chave;

- otimização on-page;

- otimização off-page;

- SEO técnico;

- análise, ajustes e relatórios;

- estratégia de conteúdo de qualidade;

- atualização contínua.

Qual é a relação entre SEO e Mídia Paga no Google?

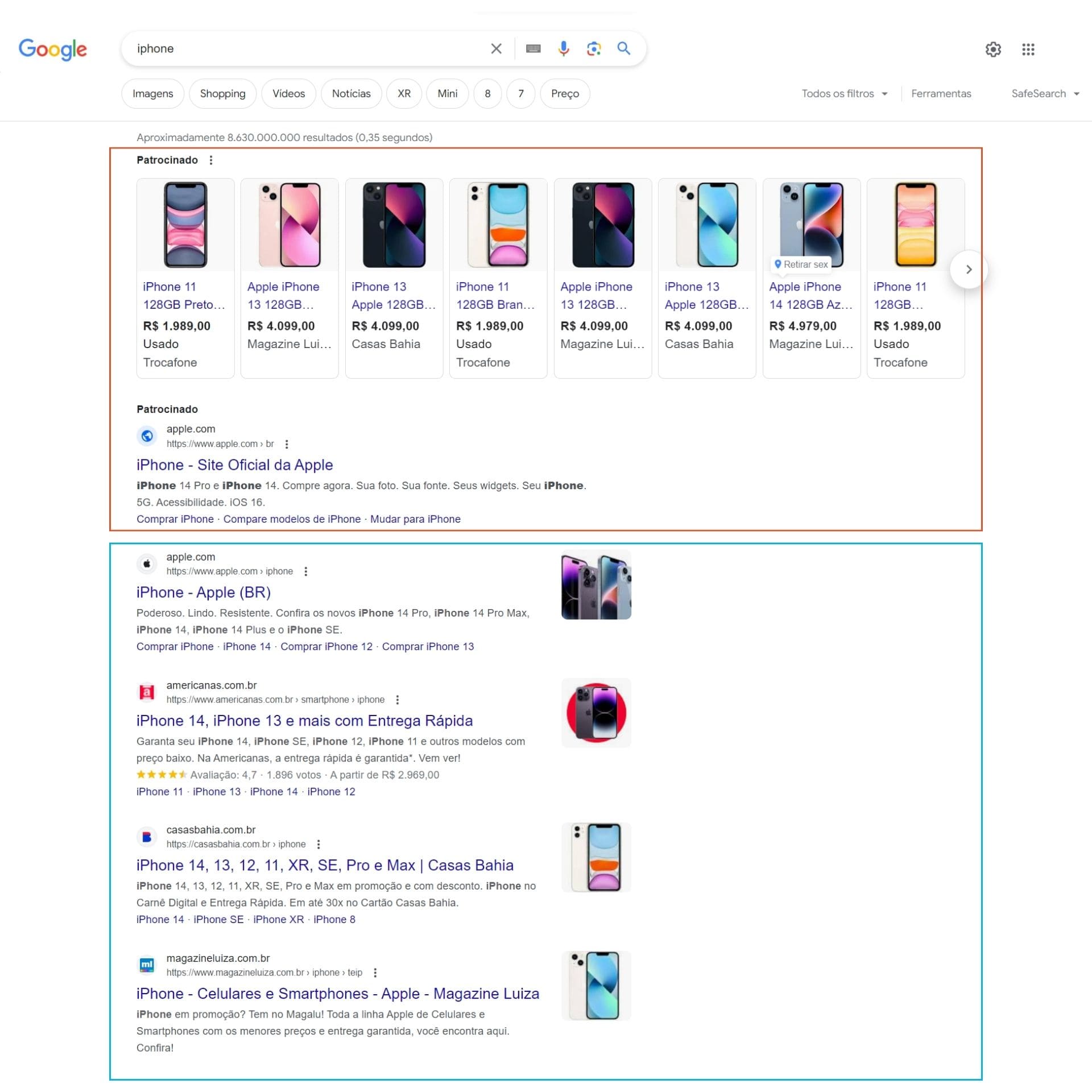

É essencial distinguir entre os resultados orgânicos e os patrocinados nos motores de busca. Como ilustrado na imagem, os resultados orgânicos são destacados em azul, enquanto os resultados patrocinados aparecem em laranja:

Embora a diferença visual possa parecer sutil, na prática, a distinção é significativa. Para aparecer nos resultados patrocinados, é necessário investir em publicidade por meio do Google Ads. Por outro lado, alcançar uma posição de destaque nos resultados orgânicos demanda um esforço contínuo e a aplicação de uma variedade de estratégias de SEO.

Uma pesquisa realizada pela Oberlo em 2022 sobre as estatísticas do Google revelou que 90% dos participantes disseram que “provavelmente clicariam no primeiro conjunto de resultados” apresentados pelo buscador. De fato, 93% do tráfego online é gerado através do Google, sendo que uma grande parcela desse tráfego vem das buscas orgânicas.

Como fazer SEO?

Fazer SEO (Search Engine Optimization) envolve uma série de estratégias e técnicas destinadas a melhorar a visibilidade e o posicionamento de um site nos resultados orgânicos dos motores de busca, como as mencionadas anteriormente neste artigo.

Além disso, implementar uma estratégia de SEO eficaz requer tempo, paciência e um compromisso contínuo com a qualidade e a melhoria. Embora os resultados possam não ser imediatos, uma abordagem consistente e bem planejada ao SEO pode levar a um aumento significativo na visibilidade do seu site, no tráfego orgânico e, em última análise, no sucesso do seu negócio online.

Como fazer um bom SEO no Google?

Fazer SEO no Google envolve otimizar seu site para aparecer nos resultados orgânicos de pesquisa do Google, o maior motor de busca do mundo. Aqui está um guia passo a passo sobre como otimizar seu site para o Google:

- entenda o algoritmo do Google;

- faça pesquisas de palavras-chave;

- invista na otimização on-page;

- não se esqueça da otimização off-page;

- dedique-se ao SEO técnico;

- utilize ferramentas como o Google Search Console;

- crie e otimize seu conteúdo;

- analise e ajuste sempre que necessário;

- continue aprendendo e adaptando-se às novas tendências e atualizações do algoritmo.

Como o SEO funciona?

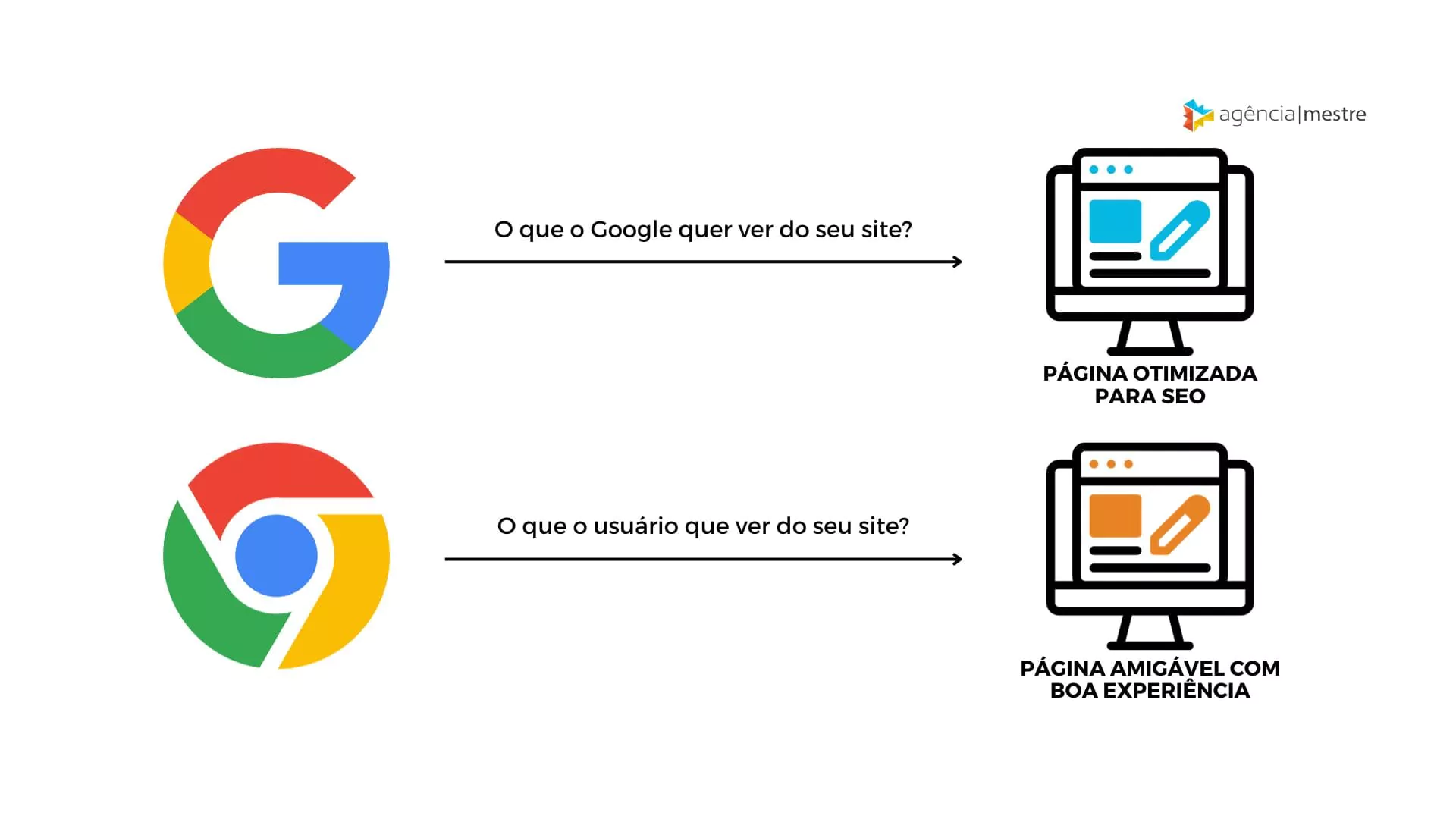

Entre estas técnicas e métodos, podemos dividir o SEO em duas frentes distintas: os fatores On-Page e os fatores Off-Page (ou link building). Pela tradução direta, os fatores On-Page caracterizam-se por técnicas que alteram ou melhoram aspectos internos do site (também chamado de “SEO for site”). Já os Off-page caracterizam-se pelos aspectos externos, como links.

O que são as otimizações de SEO? Conheça diferentes técnicas

As otimizações de SEO são técnicas que melhoram a visibilidade e o posicionamento de um site nos resultados orgânicos dos motores de busca, como o Google. Seu objetivo principal é aumentar a quantidade e a qualidade do tráfego para o site através de resultados de pesquisa naturais, não pagos.

Sendo assim, as otimizações de SEO abrangem uma ampla gama de ações, desde ajustes técnicos na estrutura do site até a criação de conteúdo relevante e atraente para o público-alvo. Confira as principais delas:

Fatores On-Page:

Inclui todas as medidas de SEO aplicadas diretamente dentro do site para melhorar sua posição nos motores de busca. Isso envolve:

- título da página, definido pela title tag (<title>);

- otimização de conteúdo, com o uso de palavras-chave relevantes de forma estratégica nos títulos, cabeçalhos, corpo do texto e metadescrições (metadescriptions);

- estrutura do site e URLs, ao garantir que o site tenha uma estrutura lógica, URLs amigáveis e utilize tags HTML corretamente;

- uso de HTML Tags (Heading Tags H1 a H6) para organizar o conteúdo;

- estratégias de linkagem interna;

- otimização de imagens, com tamanho reduzido e utilizando o atributo alt para descrevê-las, melhorando a velocidade de carregamento e a acessibilidade;

- melhoria da experiência do usuário (UX), garantindo que o site seja fácil de navegar, rápido e responsivo em diferentes dispositivos;

- E por fim, mas não menos importante, o Conteúdo

Fatores Off-Page ou Externos:

Refere-se a ações realizadas fora do seu site que impactam o ranking nos motores de busca. Isso geralmente inclui:

- construção de backlinks para obter links de outros sites de qualidade e relevância para o seu, o que pode aumentar a autoridade do seu domínio;

- marketing de conteúdo e social media a fim de promover o conteúdo do site através de canais de mídia social e outras plataformas para gerar tráfego e links de volta;

- não se prender a números, já que a experiência do usuário é o fator mais relevante para o Google e, independentemente de quantos links a sua página tenha, eles precisam ser relevantes e fazer sentido com o conteúdo da leitura;

- Texto âncora dos links externos.

Link Building:

Link Building é o conjunto de técnicas de SEO responsável pela arquitetura interna de links de um site e pela conquista de links externos. Quando falamos de links, precisamos entender que eles produzem vários benefícios para um website, tais como:

- tornar o seu site mais visível os mecanismos de busca;

- determinar a importância de uma página, já que são utilizados pelos mecanismos de busca para determinar se uma página é significativa e relevante;

- fornecem informação extra sobre a página para as quais apontam;

- atrair visitantes e robôs de busca para sua página.

Essas estratégias são essenciais para conduzir um bom trabalho de SEO. Segundo um estudo realizado pela HubSpot com analistas da Web em 2023, as principais estratégias de SEO estão fortemente relacionadas com otimização:

Mas, vale reforçar que os fatores mencionados acima são apenas a “ponta do iceberg”, uma vez que o próprio Google afirma que existem centenas de fatores que eles observam para classificar uma página ou site em seus resultados, conhecidos como “fatores de ranqueamento” ou Google Search Essentials.

Por isso, criamos um e-book de SEO gratuito, com a finalidade de mostrar como você pode realizar SEO em seus projetos. Basta clicar aqui e solicitar o e-book.

Qual a Vantagem do SEO?

A essência do trabalho de SEO é atrair novos visitantes e, com mais visitas, aumentam as suas chances de conversão (lead ou compra). Logo, com um bom trabalho de SEO, você pode aumentar as suas vendas, número de visualizações de página, número de leads, assinantes de feeds, ou qualquer que seja a sua métrica de conversão.

É importante frisar que SEO é um trabalho de médio/longo prazo que visa aumentar a quantidade de visitantes por meio de entendimento do seu website e confiança/autoridade percebida pelos mecanismos de busca. Uma vez feito o trabalho, quando o site aparecer bem nas pesquisas, será por credibilidade/entendimento.

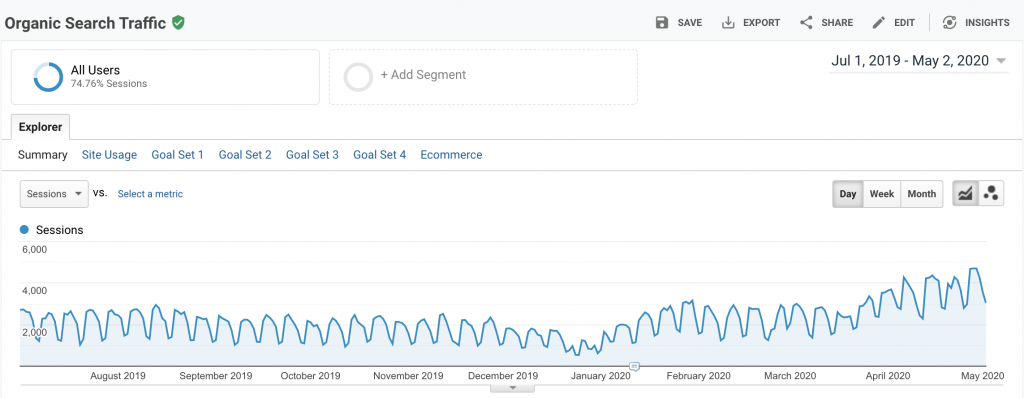

Em média, notamos que um projeto de SEO começa a demonstrar resultados a partir de 4 meses de projeto. Antes disso, somente se o website tiver algum problema estrutural ou algo grave que impeça os mecanismos de busca de ler o conteúdo/website.

Como você pode notar abaixo, temos bons projetos de SEO com resultados a partir de 4 meses de projeto:

Quais são os benefícios do SEO para empresas?

Além da atração de visitantes com potencial para se tornarem clientes, que já é um dos maiores benefícios do SEO para as empresas, a estratégia de SEO – quando bem aplicada – pode ser relevante para:

Aumentar sua credibilidade e autoridade online

Os usuários consideram que os sites que aparecem nas primeiras posições do Google são os mais confiáveis e, na prática, essa é a realidade. Isso porque o buscador conta com diversos algoritmos para medir a relevância e confiabilidade da sua página; ou seja, quanto melhor posicionado, mais oportunidades de conquistar novos clientes.

Experiência do usuário

Esse é um dos fatores de ranqueamento mais relevantes para o buscador e, com os esforços para tornar sua página mais rápida e seu conteúdo mais legível, o usuário terá sempre uma experiência agradável e lembrará do seu site.

Maiores taxas de conversão

O objetivo do SEO é gerar mais tráfego orgânico para o seu site, mas de forma qualificada. Com essa estratégia, você consegue aumentar sua relevância para os termos e palavras-chave relacionadas ao seu negócio e atrair pessoas verdadeiramente interessadas nos seus produtos ou serviços.

Visibilidade sustentável

A publicidade online é uma estratégia muito eficiente e, quando combinada com SEO, pode trazer ainda mais resultados. No entanto, com a mídia paga, o seu negócio precisa estar sempre investindo para manter sua visibilidade online, enquanto a estratégia de SEO promove mais destaque para a sua marca de forma orgânica.

Relacionamento com o público

As estratégias de SEO são construídas com o apoio do Marketing de Conteúdo, portanto, ela promove a geração de materiais e conteúdos relevantes que aproximam a sua marca dos consumidores, mesmo quando eles não estão intencionalmente buscando realizar uma compra.

Saiba mais sobre a Consultoria de SEO

Agora, você já sabe os princípios do SEO e, a partir deste ponto, nosso guia mostrará mais detalhes sobre essa estratégia.

O SEO é uma das principais estratégias para conquistar resultados significativos e mais visibilidade no meio digital, no entanto, exige atenção aos detalhes e muito conhecimento técnico.

A Agência Mestre é uma das mais antigas agências e renomadas a oferecer este serviço no Brasil. Com ele, é possível aumentar as receitas e o número de clientes oriundos de busca orgânica. Se você quer contratar uma agência séria, com profissionais experientes, confira os detalhes da nossa consultoria de SEO.

Técnicas de SEO: Fatores On-Page

Em SEO, os fatores de otimização On-Page objetivam a melhoria de pontos diretamente ligados ao seu site e ao seu código fonte, por isso, eles podem envolver alguma necessidade de programação ou toque de criatividade para obter os melhores resultados com estes fatores.

Os principais fatores on-page que a sua empresa precisa trabalhar para conquistar bons resultados com SEO são:

1. Título da página

De todos os fatores On-Page, o título da página, definido pela title tag (<title>), é o mais importante ponto a se trabalhar! Basicamente, é quase uma unanimidade que este seja o fator mais importante em um site (salvo o conteúdo, que não será tratado aqui como um fator, já que é o mínimo esperado de um site), por isso, a title tag merece toda a atenção do SEO.

A “meta title” ou “title tag” é um elemento HTML do seu site que especifica qual é o título de cada página ativa (ou inativa) que existe. Esse título será exibido nos resultados de pesquisa dos mecanismos de busca e na barra de título do navegador do usuário.

O título da página é a primeira impressão que os usuários têm do seu conteúdo. É extremamente importante que esse elemento esteja alinhado ao conteúdo do seu site, portanto, ele deve ser único e exclusivo para cada página que você criar. Vamos conferir algumas práticas para criar títulos relevantes para o seu site:

Uso de palavras-chave e nome do site nos seus títulos

Na composição do título de cada página, é primário que sejam utilizadas as palavras-chave mais pertinentes ao conteúdo oferecido. Além disso, é interessante que o nome do site apareça também, assim, cultiva-se uma fixação da marca do site e, à medida que as pessoas se deparam com suas páginas nas ferramentas de busca, elas começam a reforçar a credibilidade do seu domínio e da sua marca frente àquele assunto.

Uma pesquisa realizada pela BrightEdge mostra que os títulos que contêm palavras-chave estão no Top 5 do Google em 85% das vezes.

Preferencialmente, o nome do site deve vir depois do título contextualizado da página, de forma semelhante à procedida na Agência Mestre:

- Guia de SEO | Agência Mestre

- SEO na Title Tag – Melhore os Títulos do seu Site | Agência Mestre

- Ferramentas de SEO | Agência Mestre

Quando a sua marca tem relação com o conteúdo, tem-se o benefício adicional de carregar mais uma ocorrência de uma palavra-chave importante no título da página. Quando não tem, ainda assim é válido utilizar o nome do site ou empresa para fixação/exposição da marca.

Quantidade de caracteres nos títulos das suas páginas

Além de observar a estrutura do título, outro ponto a se prestar atenção é a quantidade de caracteres utilizados no título das páginas. Não existe nenhuma regra definindo a quantidade ideal, mas o bom senso e um pouco de observação ajudam a chegar a um bom número.

Tradicionalmente, recomenda-se o uso de 58 caracteres, pois assim, assegura-se que cada palavra no título será mostrada por inteiro nos resultados de pesquisa.

Mas, com um pouco mais de observação sobre o título, percebe-se que não há perda de posicionamento se a quantidade de caracteres ultrapassa essa quantidade. Claro, não interessa que sejam 100 ou 120 caracteres, mas cruzar a linha dos 60 e mantidos abaixo de 80, ainda consegue-se um bom efeito de SEO.

O ponto negativo de cruzar esses limites é que, embora o mecanismo de busca (Google por exemplo) capture a informação que está além dos 58 caracteres, o usuário não vai ver, pois, tipicamente, os mecanismos de busca utilizam reticências (…) quando o título fica grande demais.

Se a perda for pequena para o usuário e houver vantagem para o mecanismo de busca, então vale a pena utilizar títulos maiores. Mas, lembre-se que a experiência do usuário é o principal fator de ranqueamento.

Sopa de letrinhas ou manchetes?

Mas antes de pensar na quantidade de caracteres, o papel do SEO é pensar em um título chamativo e criativo, informativo e curioso, para, de fato, atrair o clique do usuário.

Não é interessante montar um título com uma pura e simples repetição de palavras-chave:

- SEO, Otimização de Sites, Search Engine Optimization, …

Essa ação, além de apresentar uma péssima experiência para o usuário, pode ser entendida como uma estratégia para “burlar” os fatores de ranqueamento dos buscadores e gerar uma penalização para o seu site.

É muito mais pertinente que o título seja informativo sobre o que será encontrado no conteúdo de tal página e não uma salada de palavras-chave. O ideal é que ele seja como uma manchete de jornal, de modo a fazer o usuário se interessar e querer saber mais sobre o conteúdo da página.

Esta é a hora de exercer a criatividade e produzir títulos inteligentes, misturando a necessidade de palavras-chave para o SEO com a transmissão de informação.

2. Meta Tags

Seguindo com os fatores on-page, existem mais meta tags se prestar atenção, como a meta description tag e a meta keywords. Com certeza, muitos vão torcer o nariz ao ler isso e pensar em outras meta tags que, inclusive, têm funcionalidade em SEO, como a meta tag robots. Mas vale frisar: vou falar das meta tags mais importantes para o SEO!

Muitos profissionais ou iniciantes perguntam sobre a importância da meta keywords, já que, hoje em dia, ela é irrelevante para os principais mecanismos de busca, pois eles as ignoram, mas vou mantê-las aqui por razões de educação da audiência.

Um dos pontos a destacar quando se está fazendo a otimização on-page de um site é a criação de meta tags para cada uma de suas páginas. Quando falamos da meta description, é válido e deve ser uma regra:

Criar meta descriptions únicas, criativas e que seu conteúdo seja fortemente relacionado ao conteúdo da página em questão.

Isso faz toda a diferença na oportunidade que você terá em receber cliques do usuário, uma vez que o conteúdo da meta description não é utilizado pelos buscadores para posicionar uma página diretamente.

Meta Tags de Qualidade

Criar uma regra para que as meta tags (description) seja “montada”de forma automático, a partir do assunto da página, é uma alternativa muitas vezes viável e prática, mas com certeza a criação manual de meta tags gera resultados muito mais relevantes. Claro que isso não é possível de ser feito para 100% dos sites e das páginas, mas a automatização deve ser deixada para último caso mesmo.

A qualidade de uma meta tag tem dois lados a serem avaliados:

- Como uma pessoa avalia a meta tag

- Como um buscador avalia a meta tag

Para uma pessoa, a meta tag precisa ser chamativa, interessante, informativa, curiosa e com um toque de call-to-action. Para um buscador, a meta description é simplesmente relevante no quesito textual, mas acaba-se utilizando informações sobre taxa de cliques (CTR) para privilegiar um pouco aquele resultado.

Quando falamos sobre meta keywords, basta selecionar as palavras importantes da página e listá-las juntamente com suas variações e sinônimos. Apesar de a meta keywords não ter valor para os mecanismos de busca, alguns sistemas de social bookmarking podem ainda sim usá-las para classificar o conteúdo da página em seu sistema. Para esses casos, fica interessante manter o uso de meta keywords nas páginas do site.

Meta Tags: Quantidade

Quantidade também é uma informação a se ficar atento no que diz respeito às meta tags, mas, claro, não é sobre a quantidade de meta tags, e, sim, a quantidade de caracteres em cada meta informação. Esse, provavelmente, é o maior desafio na criação de meta tags.

Por exemplo, da mesma forma que ao criar um título, é interessante que apareça o nome do site, mais o título da página e mais algum outro detalhe relevante, tudo isso sem ir além de 58 caracteres; para a meta description, a preocupação é não cruzar 160 caracteres e ainda passar o recado sobre o conteúdo da página utilizando os termos importantes para a página.

Para manter o controle sobre a quantidade de caracteres, procure um contador de caracteres ou faça uso de alguma ferramenta de SEO que lhe auxilie nesse processo.

Essa informação sobre a quantidade de caracteres em cada meta tag é importante para que você tenha controle do que será exibido ao usuário, fazendo com que as suas chances aumentem em receber um clique nos resultados da busca.

Claro que cada valor não precisa ser seguido à risca. Ultrapassar os 158 caracteres na meta description não resulta em uma penalização ou demérito por parte dos buscadores. Contudo, se você utilizar 100 caracteres de pura repetição de palavras-chave não será algo bem visto pelos buscadores. É preciso, realmente, achar o ponto de equilíbrio entre quantidade e qualidade.

3. HTML Tags: Heading Tags (H1 – H6)

As tags heading (H1 – H6) são as principais tags de organização do seu conteúdo. Elas foram criadas com o intuito de marcar pontos em destaque no seu conteúdo, mas nem sempre elas são usadas de forma adequada para fornecer ao usuário uma boa experiência na leitura.

Muitas vezes, um conteúdo desorganizado pode não ser visualmente perceptível para o usuário, mas certamente os buscadores podem ler essa informação e – dessa forma – considerar que o seu site não vai oferecer uma boa experiência para o usuário.

Quando falamos de fatores on-page, em um de seus vídeos, Matt Cutts respondeu a esse questionamento informando que é sim útil utilizar as heading tags de forma moderada e organizada – utilizar com o fim ao qual foi proposto: A organização do conteúdo em tópicos e subtópicos.

Os mecanismos de busca definiram que as heading tags possuem um grau de importância para o posicionamento de sites obedecendo a mesma filosofia que nós usamos na leitura dos subtítulos de um texto, por exemplo. Com esta importância dada às heading tags, é fundamental o SEO utilizá-las de forma clara e efetiva.

Uso Correto de Heading Tags

A tag <h1> deve ser usada como o título principal da página, e de conteúdo muito parecido (ou igual) ao conteúdo da própria title tag. É a heading tag mais importante para uma página, informando o principal conteúdo da página.

Obviamente, nela deve aparecer a principal palavra-chave da página, ficando visualmente destacada para o usuário. Desta forma, o destaque visual indica ao visitante o principal foco da página, e o fato de ser a tag <h1>, fica indicado para o mecanismo de busca esse mesmo foco.

Subsequente a tag <h1>, a tag <h2> deve ser utilizada quando a página abordar subtópicos referentes ao tópico mencionado no <h1>; é aí que são utilizadas variações de palavras-chave. Você pode optar por sinônimos, palavras-chave relacionadas e, claro, aumentar (de forma moderada) a ocorrência da palavra-chave principal pontos importantes, aumentando a relevância da página em seu tema.

Daí em diante, o processo é o mesmo para as demais tags. Se for utilizada a tag <h3>, ela deve ser um subtema do que está sendo tratado no h2. Para as tags h4 -h6, funciona da mesma maneira. Em vias práticas, raramente uma página irá além da heading h3, a menos que seu conteúdo seja muito extenso e, de fato, seja necessária a divisão em tópicos cada vez mais refinados, como é o caso deste guia.

É importante fixar que cada página deve conter um, e apenas um, <h1>. Contudo, quando se utiliza a formação HTML5, você deve ter no máximo uma tag <h1> por seção.

Outro fato muitas vezes esquecido e que consiste de um erro é quebrar a hierarquia das heading tags. Esta hierarquia define o uso correto das heading tags por ordem de relevância e sequência de uso no código HTML de uma página. Por exemplo:

H1

- H2

- H2

- H3

- H4

- H4

- H3

- H3

- H2

Esta estrutura segue o aninhamento de heading tags e esta é a ordem segundo a qual essas tags devem ser encontradas no código, ou seja, ao se fazer a leitura (leitura mesmo) do código HTML, a primeira heading tag encontrada deve ser o h1. Prosseguindo a leitura, deve ser encontrado um h2, que pode estar dividido em headings h3 e assim por diante.

Também, fica válido um novo subtópico pertencente a um h2 ou um novo subtópico marcado em um h2, derivado do tema principal marcado pelo h1 da página.

O contrário de seguir essa hierarquia ficaria assim, por exemplo:

H3

- H2

- H1

- H4

- H3

- H2

- H4

- H4

- H2

As heading tags são semanticamente definidas para estabelecer títulos e subtítulos em um conteúdo, e assim elas devem ser utilizadas.

Exemplo de Uso

O uso apropriado de heading tags pode ser exemplificado da seguinte maneira:

- <h1>SEO – Otimização de Sites</h1>

Neste h1, ficou definido o tema principal da página: ela é sobre SEO.

- <h2>Estratégias de SEO</h2>

Já no texto do H2, algo mais específico, ou seja: uma subseção do H1, mas ainda com keywords relacionadas com a página. Isso ajuda as ferramentas de busca e, principalmente, o usuário a achar e classificar o que o site oferece.

- <h3>Otimização On-Page</h3>

Assim como no H2, o H3 tem que ser um complemento do Hx(1-5) superior. E essa regra deve ser seguida até a tag H6, criando relacionamentos e organização de conteúdos de modo a orientar, tanto mecanismos de busca, quanto visitantes, sobre o que é oferecido na página.

4. Palavras-chave: Conteúdo e URLs

O uso de palavras-chave deve ser planejado basicamente em 2 ramos: conteúdo e URL.

Para conteúdo, é importante definir quais palavras serão utilizadas em cada página, bem como a distribuição de todas palavras pelo conteúdo do site. Já as URLs devem ser criadas baseadas no conteúdo que ela vai hospedar, geralmente, apresentando uma variação da palavra-chave principal de tal página.

Desenvolvimento do Conteúdo em SEO com Planejamento de Palavras-chave

Aliado à ideia de organizar o conteúdo em subtópicos e definir heading tags, está o planejamento do uso de palavras-chave ao longo de uma única página, bem como de todo o site.

A cada novo subtópico, ramo ou derivação de tema, uma nova palavra-chave surge (e são chamadas de keywords de Long Tail) e deve ser bem cuidada. É muito comum entre SEOs ou donos de sites que se detenha toda atenção sobre a keyword principal do negócio, por gerar um volume alto de buscas e visitas individualmente, mas isso é um erro grave.

Uma análise sobre as visitas de todas keywords de entrada em um domínio pode mostrar que, embora individualmente uma única palavra possa gerar, por exemplo, 1000 visitas (e ser a principal entrada de visitas isoladamente) contra 200 ou 100 visitas sendo geradas por keywords secundárias, o volume de visitas por keywords secundárias frequentemente supera o volume dessa keyword principal.

Ou seja, embora uma única palavra, a principal, possa gerar 5 vezes mais visitas que uma secundária (1000 vs. 200 visitas), todo o conjunto de visitas por keywords secundárias, supera essa keyword principal (1000×1 vs. 200×50 visitas).

Por isso a importância de considerar, também, as palavras secundárias e procurar listá-las todas para se ter uma melhor visão sobre o que pode ser conteúdo para uma página ou para um site.

É como escrever um conteúdo pensando em otimizar a palavra “SEO”, mas também considerar o uso de “Estratégias de SEO”, “Análise de SEO”, “Otimização SEO” ou outras combinações dentro de uma mesma página e distribuídas por todo o site.

Otimização de URLs com Planejamento de Palavras-chave em SEO

Uma URL óbvia é uma ótima URL. Quando se olha para a barra de endereços do navegador e se consegue saber qual o conteúdo da página, antes mesmo de carregar esse conteúdo, temos uma URL perfeita. Uma única e simples linha que transmitirá informação suficiente sobre conteúdo e chamará atenção por si só.

A otimização de URL começa com a escolha do nome do domínio. Preferencialmente, a URL do domínio deve conter a keyword principal a se trabalhar no site. É notável como Search Engines valorizam e posicionam bem sites cujo nome do domínio são idênticos ou muito próximos dos termos buscados. A razão para isso é que a Search Engine interpreta isso como uma pesquisa navegacional.

Uma pesquisa navegacional se caracteriza por ser buscado o nome de um site, é como pesquisar “Agência Mestre” – é óbvio que o melhor resultado a se retornar será www.agenciamestre.com. Assim, se a sua keyword principal é “ração para cachorro”, “camisetas de futebol”, etc., e o seu domínio for www.racaoparacachorro.com.br, www.camisetasdefutebol.com.br, etc., a Search Engine vai interpretar as buscas nessas keywords como navegacionais, favorecendo os sites.

Já no quesito URLs de conteúdo (das páginas do site), quanto mais curta a URL, mais fácil será lembrá-la, copiá-la, passar adiante, usá-la de todas as formas possíveis, facilitando sua divulgação. E, de preferência, que sejam URLs sem parâmetros:

- agenciamestre.com/artigos/artigo-sobre-seo

Ao invés de:

- agenciamestre.com/artigos.php?id=132

Mesmo sendo um único parâmetro, é fácil observar que na primeira URL há uma ocorrência da palavra “SEO”, o que aumenta a relevância da página em uma busca por SEO ou artigo sobre SEO. Outro detalhe, é que números dificilmente agregram algum valor para a URL, é muito melhor o uso de palavras. Casos como “Copa do mundo 2010”, o número na URL vai fazer diferença, mas no caso geral, números não agregam valor.

Outro ponto a se observar é o separador das palavras na URL. São aceitos diversos por Search Engines, como +, _ e -. Não tenha dúvidas, vá de hífen (-) como separador das palavras, tal como no primeiro exemplo anterior. É a forma mais comum e mais difundida, não há razão para inventar ou utilizar outros separadores.

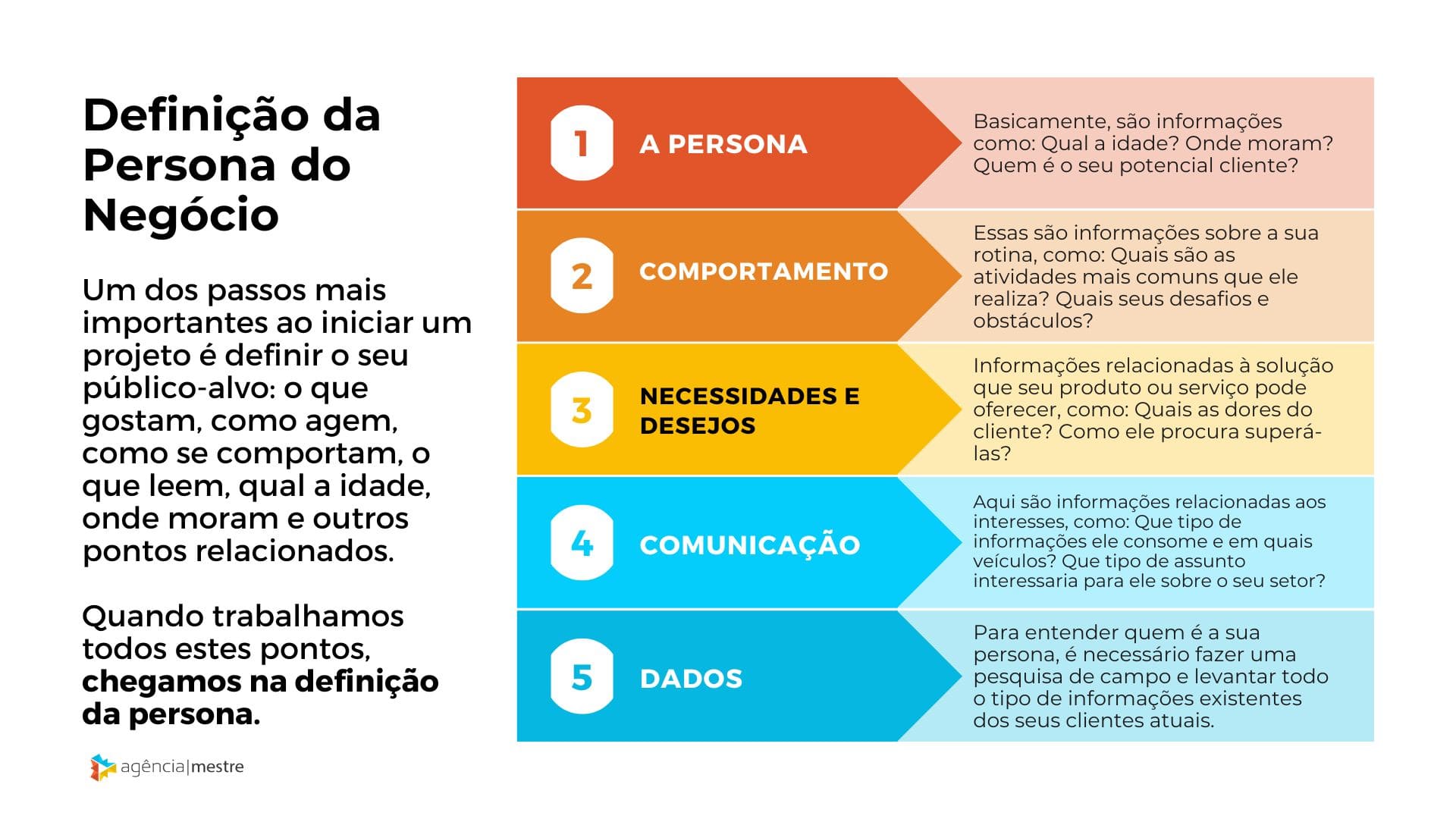

Pesquisa de Palavras-Chave

A Pesquisa de Palavras-chave é uma estratégia em SEO que consiste em saber o que as pessoas, especialmente a sua persona, procuram na Internet. Normalmente nos perguntamos: quais as palavras-chave que devemos usar em um site para que mais pessoas cheguem ao nosso conteúdo?

Para encontrar as palavras-chave corretas que devem ser trabalhadas em seu projeto de otimização de sites é necessário conhecer muito bem o conteúdo do site e descobrir como as pessoas tentam encontrá-lo – as palavras utilizadas exatamente. Para isso, o próprio conteúdo do site deve dar as primeiras dicas na sua pesquisa.

Ainda no começo, é importante identificar o segmento de mercado dos leitores do site. As palavras-chave podem não estar explícitas nas páginas do site, no entanto, podemos usar palavras relacionadas, palavras que os leitores utilizam para falar do seu conteúdo.

Neste primeiro passo de entender a persona em si, você precisa responder estas perguntas:

- Qual a sua idade? Onde moram?

- O que gostam de ler? Quais sites visitam? Quais seus gostos?

- Como eles preferem se comunicar? Como se comunicam? Por quais redes sociais?

- O que aspiram para suas vidas? Quais seus sonhos? Suas metas?

Esta tarefa associada ao entendimento da persona faz toda a diferença para você conhecer bem para quem deve criar os conteúdos, sendo este um dos passos mais importantes no início do seu projeto.

No caminho para encontrar as palavras-chave corretas, comece do amplo para obter o específico. Leia sua página e coloque num rascunho todas as palavras que você julgar importantes para a página.

Em seguida, analise e observe se realmente todas as palavras escolhidas estão relacionadas a página específica que você está trabalhando ou se elas não estão se referindo ao site de maneira geral. Este passo te dará uma noção mais clara do que você poderá trabalhar.

Em seguida, pense em alguns sinônimos e formas de se utilizar estas palavras, para que você tenha um leque maior de opções. Ainda neste passo também devem ser identificadas as palavras negativas ou seja, as que estão fora do contexto para que não sejam colocadas palavras-chave com baixo grau de similaridade no trabalho de SEO que você está fazendo. Utilizar sinônimos pode ser interessante, mas o foco não pode ser perdido.

Com estes passos feitos, é hora de expandir esta lista com auxílio de ferramentas e começar a ordenar por quais palavras-chave começar a otimização do site baseando em:

- Volume de tráfego

- dificuldade de enfrentar a concorrência

- e volume de conversões possíveis com aquela palavra chave.

Ferramentas Para Pesquisa de Palavras-chave

Talvez eu seja uma das pessoas que mais ama ferramentas em projetos de SEO e por isto, constantemente testo ferramentas que possam ajudar a facilitar e agilizar o nosso trabalho como profissionais de SEO.

A primeira fonte de ferramentas que você precisa ter em mente é o próprio Google. Ele fornece 3 formas de entendermos mais o público e muitas pessoas sequer conhecem ou dominam a forma com que você pode utilizar estas ferramentas.

As 3 formas que vamos falar a frente são: Keyword Planner, Google Trends e Google Suggest.

Google Keyword Planner ou o antigo Keyword External Tool

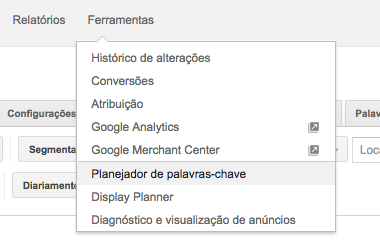

Para uma campanha de tráfego pago o Google disponibiliza uma ferramenta integrada ao Google Adspara que o profissional ou dono de negócio consiga facilmente descobrir termos que a sua audiência (ou persona) estejam buscando dentro do mecanismo de busca.

Esta ferramenta é chamada Keyword Planner e, antigamente, se chamava Keyword External Tool. No início esta ferramenta era totalmente liberada, sendo que você sequer precisaria de login para começar a “brincar” com ela.

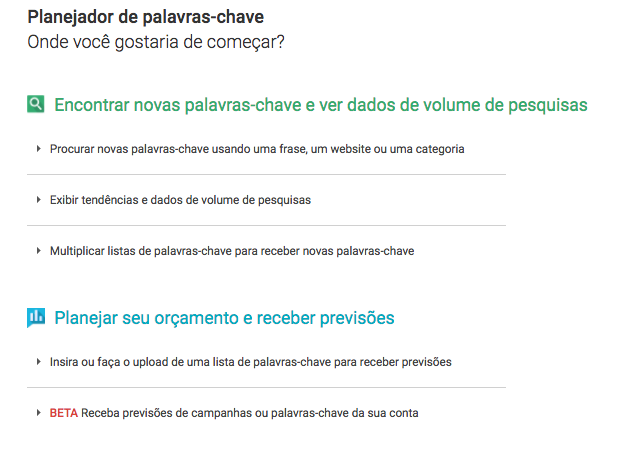

Assim que você escolhe a opção dentro do Google Ads, você é levado para uma tela onde precisa decidir qual ação busca realizar:

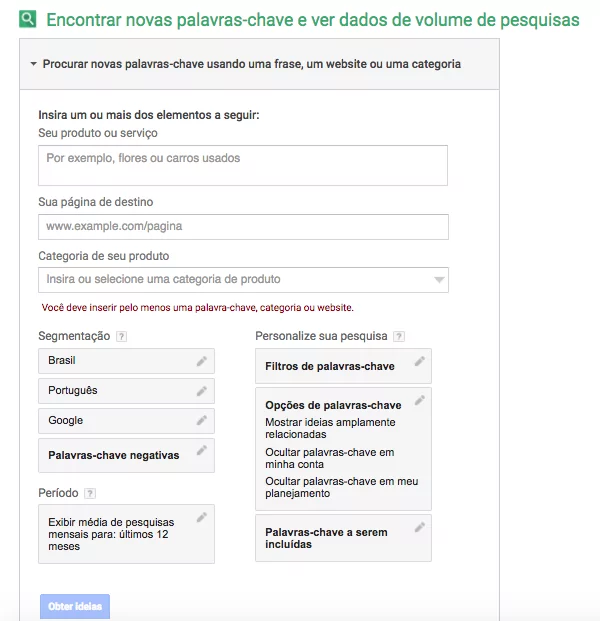

Escolha a primeira opção e depois você terá uma caixa com várias opções para você:

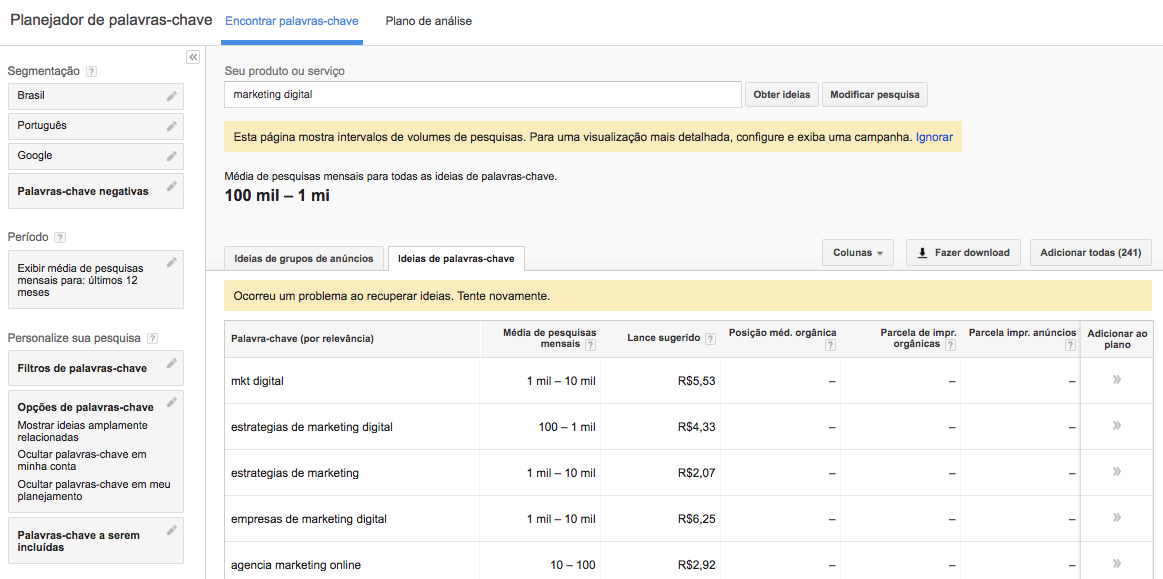

Em “seu produto ou serviço” você pode incluir as principais palavras-chave do seu projeto ou da página que está trabalhado. Os outros campos você pode deixar como estão. Em seguida clique no botão “Obter Ideias”. Assim uma página de resposta irá se abrir, como esta:

Na lista de resposta da ferramenta, é interessante habilitar a exibição de todas essas informações no drop down sobre as “Colunas”, e assim obter todas as informações. A partir daí, basta analisar cada conjunto de palavras-chave reordenando segundo a importância de cada coluna para obter as mais interessantes, sejam as mais caras, as de maior volume de busca, uma combinação de tudo, enfim, o que for mais interessante.

Outra opção de pesquisa nesta ferramenta, não tão utilizada quanto a primeira, é inserir a URL do site no campo especificado. Neste caso, a própria ferramenta analisa o conteúdo da URL digitada e monta a lista de termos relacionados baseando-se nesta análise do conteúdo.

Google Trends

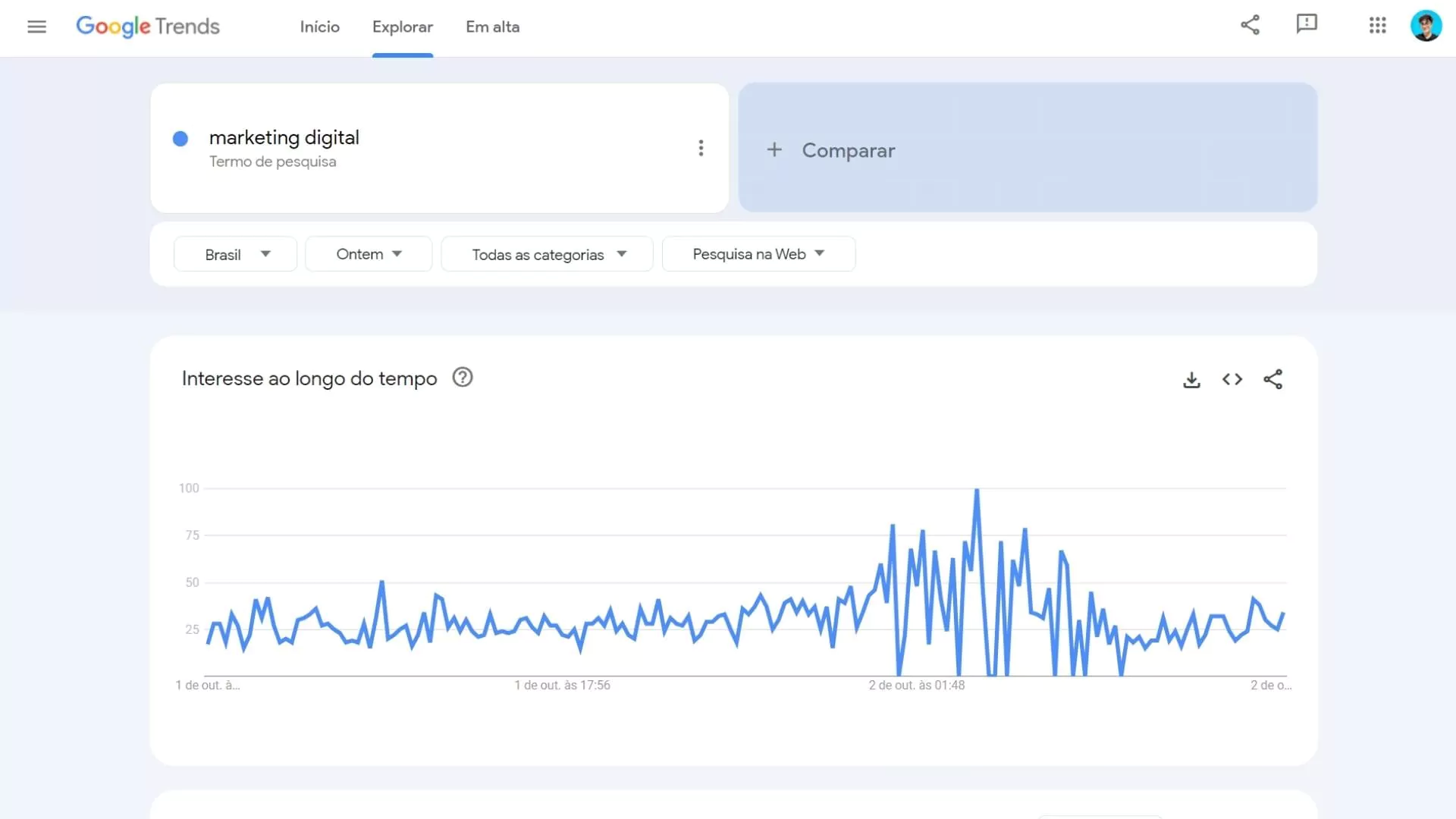

O Google Trends é uma ferramenta desenvolvida pelo Google para entender o nível de buscas para um determinado termo.

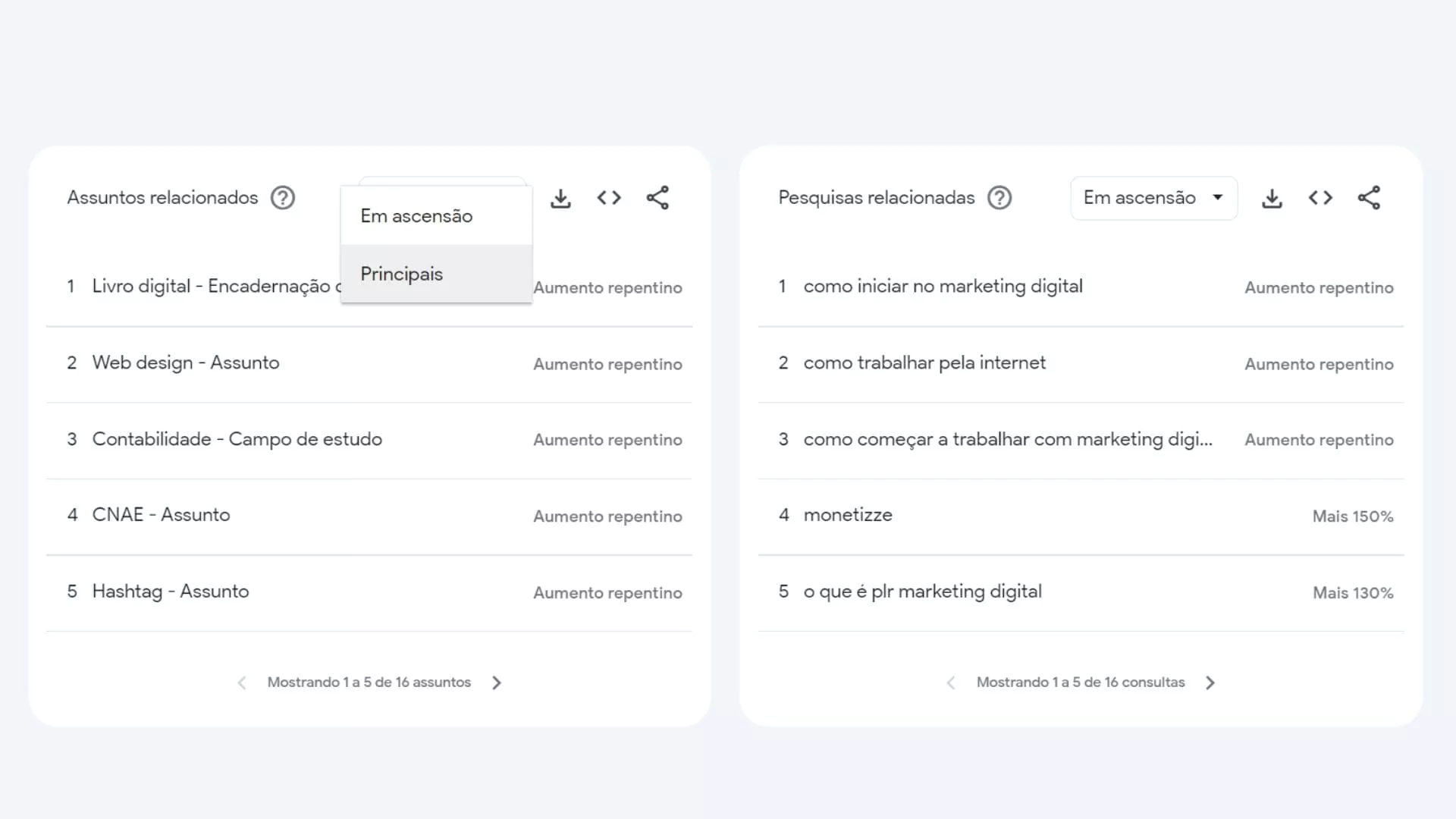

Com a ferramenta é possível analisar o comportamento de buscas de uma palavra em comparação com até 4 outras palavras. O gráfico ainda pode ser limitado por tempo ou país, possibilitando visualizar até quais os estados e cidades daquele país realizaram mais consultas sobre a palavra-chave em questão.

Quando seleciono o país Brasil e vou para a parte de baixo da ferramenta, encontro uma caixa de palavras-chave que posso usar em minhas estratégias. Ao clicar na setinha em cima da caixa, posso escolher as palavras-chave principais ou ainda descobrir as que estão em ascensão naquele tópico que eu estou buscando.

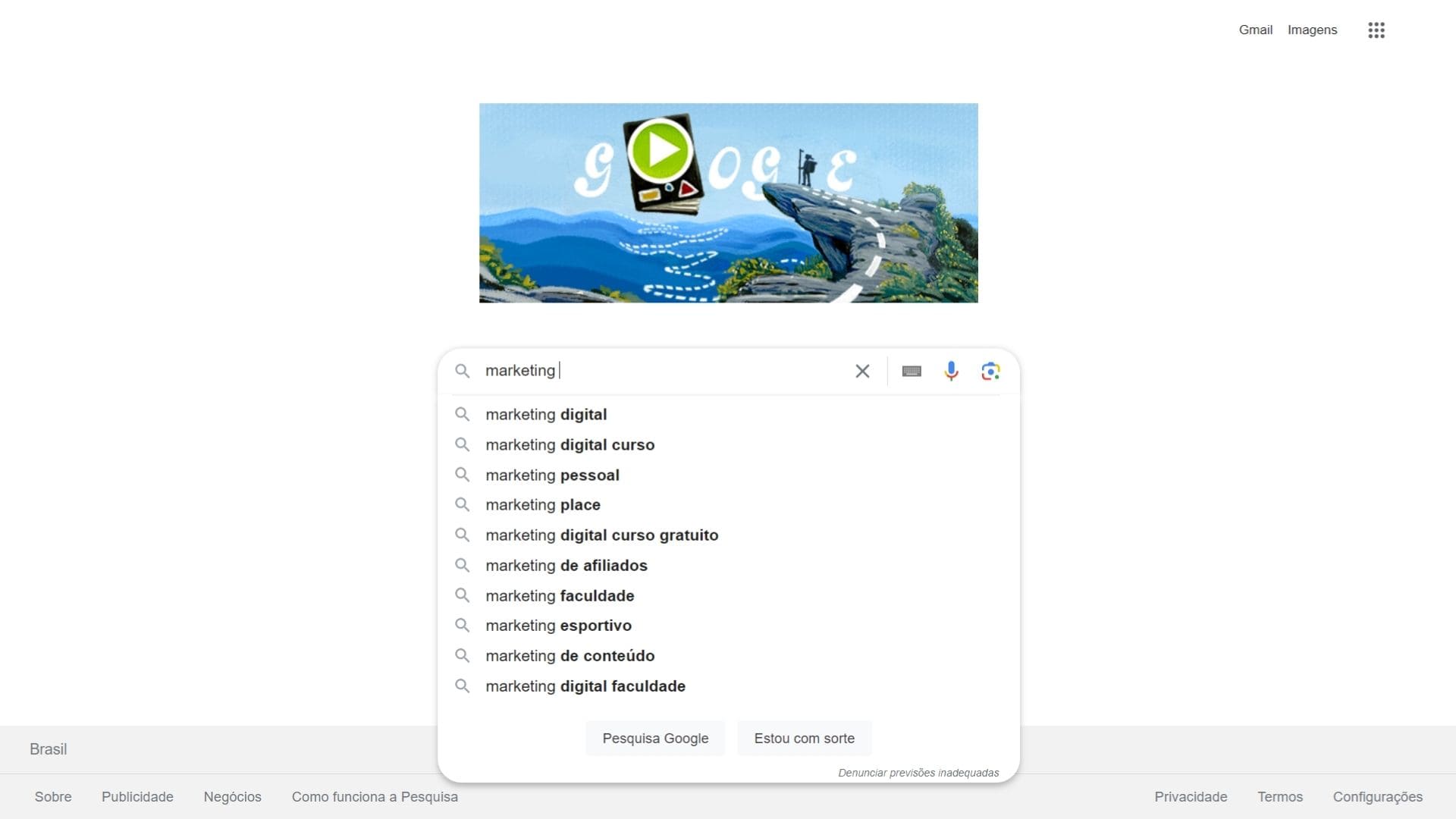

Google Suggest

O Google possui em sua página inicial, assim como nas suas páginas de busca, uma ferramenta, onde ao digitar uma palavra, ou início dela, o Google lhe dá sugestões do que você pode estar procurando, facilitando assim a sua digitação.

O interessante é observar que quase sempre o Google provê uma lista de palavras que são muito próximas do que você está procurando e neste caso são boas palavras para você utilizar na sua estratégia de SEO. Já que o Google as sugere, porque não atacá-las em suas páginas?

E melhor, se você concatenar a palavra com uma nova letra do alfabeto, ele lhe dará novas sugestões:

5. Atributo ALT de Tags de Imagem

O atributo alt aplicado em imagens é mais um item frequentemente deixado de lado na otimização de sites. Sua sintaxe HTML é a seguinte:

- <img src=”image.jpg” alt=”Uma Imagem” />

ALT é o comando usado para identificar o Alternate Text, o texto alternativo que é exibido quando a imagem não é carregada. Ele tem duas funções principais: suprir a falta dessa imagem caso ela não seja carregada e tornar o conteúdo mais acessível, para ser proporcionada uma leitura da imagem.

O importante é que este atributo funciona, realmente, como uma opção de acessibilidade para Search Engines. Ainda hoje, Search Engines não estão preocupadas em identificar imagens com base unicamente na sua composição visual; elas dependem de palavras descritivas.

Este é o propósito inicial do alt text, mas para o SEO, é mais do que isso: é uma fonte para a adição de mais uma ocorrência de uma keyword no conteúdo de uma página, afinal, a imagem também conta como conteúdo da página.

Obviamente, a imagem deve ser relacionada ao conteúdo e o alt text relacionado à imagem, assim, fecha-se o ciclo sobre a utilidade do alt text para a otimização On-Page.

Recentemente, muito se tem comentado sobre a importância de utilizar o alt text para agregar conteúdo à página e, mais uma vez, o Matt Cutts já afirmou que é importante usar o atributo e que ele deve conter até cinco palavras para não levantar a suspeita de spam.

Além do mais, 5 palavras são mais do que suficientes para definir uma imagem, mas a questão é: quais 5 palavras?

O atributo alt é uma boa opção para aplicar as variações de keywords mais complicadas de se conseguir em um texto natural: “Otimização de SEO”, “SEO estratégia”, “SEO ferramentas”, … Vale lembrar ainda que o alt text vale como texto âncora quando a imagem está inserida em links

- <a href=”…”><img src=”…” alt=”texto âncora” /></a>.

6. Linkagem Interna

A otimização dos links internos é também um passo fundamental. Os links internos são os links mais fáceis de se manipular – você pode escolher o texto âncora que desejar e fazer cada link a partir da posição de conteúdo que achar mais apropriada. Você pode escolher pelo uso de nofollow ou não; e a quantidade de links.

Além disso – e também muito importante – é o planejamento da linkagem interna como um todo. Qual página, ou grupo de páginas, tem links para quais outras páginas? É interessante observar isso e manter sempre a troca de links interna entre conteúdos relacionados.

Por último, o planejamento dos links internos serve também para garantir que a Search Engine encontre e consiga navegar por todas as páginas do domínio, desde que sejam feitos links com essa proposta. Isso significa, também, que o PageRank será distribuído entre todas as páginas do site, aumentando a possibilidade de ter todas as páginas indexadas e deixando-as mais competitivas nos resultados de busca.

Técnicas de SEO: Fatores Off-Page ou Externos

Diferente dos fatores On-Page, os fatores de otimização Off-Page não estão diretamente ligados ao site, ou às alterações no site, mas sim aos fatores fora do seu site.

No entanto, para ter uma boa estratégia de fatores off-page, o seu site precisa estar bem estruturado com os fatores on-page. Por isso, sempre falamos sobre os fatores on-page primeiro.

E, afinal, o que são fatores off-page? São estratégias de otimização e de ampliação da sua estratégia de SEO com base em elementos de “fora” do seu site, por meio de linkagens externas.

Como funciona a estratégia de SEO Off-Page?

A estratégia com fatores off-page refere-se às ações e atividades que são realizadas fora das páginas do seu site e que têm o objetivo de elevar sua visibilidade dentro dos resultados de pesquisa por meio da linkagem externa.

Para isso, a principal tática é a criação de backlinks, que consiste em criar links para as suas páginas em outros sites e páginas de alta autoridade e com segmentos semelhantes aos do seu negócio.

Vamos abordar as principais estratégias de SEO off-page:

Quantidade de Links de Entrada (Inbound links)

Links de entrada (ou Inbound Links) são os links que outros sites apontam para uma página do seu website. No início do PageRank, a regra era simples: quanto mais links, melhor.

No entanto, essa visão mudou muito desde a concepção inicial do algoritmo e, ainda sim, a quantidade de links recebidos por uma página continua a ser uma métrica importante utilizada para definir seu posicionamento em uma determinada pesquisa. Eis a razão de tanta busca por links, de sempre querer mais links.

Como descobrir os links para uma página?

Através do Google e do Yahoo você pode verificar facilmente a quantidade de links para um domínio.

No Google, entre com o operador “link:” e, em seguida, digite o domínio desejado. Já no Yahoo!, você deve entrar no SiteExplorer e digitar o domínio desejado.

É importante frisar que o operador link: do Google retorna apenas parte do conjunto de links e não a totalidade dos links que apontam para um domínio. Além disso, os resultados são gerados de forma aleatória, ou seja, não representam os links mais importantes, nem os mais recentes ou qualquer relação deste tipo. Para se ter a relação de links com o Google, somente através das Ferramentas para Webmasters oferecidas pelo Google.

Popularidade Global dos Links para o seu Site

Uma das principais métricas que os Search Engines usam na medição de “popularidade” do seu website é a diversidade de domínios que linkam para você, ou seja, não importa tanto quantos links você recebe, mas sim a quantidade de domínios diferentes que apontam para o seu website.

Um exemplo simples para este caso é saber que um site que possui 1.000 links de 1.000 domínios diferentes, irá rankear melhor do que um website que recebe 1.000 de 200 domínios diferentes. Logicamente neste exemplo estamos descartando todos os outros fatores.

Qualidade dos Links de Entrada

De nada adianta receber muitos links e de vários domínios diferentes se a qualidade dos websites ou páginas não possuem uma boa reputação. Para isto é importante saber de quem você receberá um link, olhando os fatores daquela página.

A regra aqui é simples: é muito importante que o link que você recebe seja de um site relacionado ao seu, que não esteja banido pelos Search Engines, e que seja de conteúdo original.

Mas, como sempre, surge a dúvida: Como saber se um link é de qualidade? Tipicamente, links de qualidade vem de sites de qualidade, como grandes portais e grandes marcas, mas não se limita a isso.

Sites menores de nicho específico e que são reconhecidos como autoridade no assunto que tratam, também são provedores de links de qualidade. Não é uma questão de tamanho do site, mas quão idôneo é seu conteúdo.

O problema é receber diversos links de sites de baixa qualidade ou que sejam de fato apenas spam. A princípio, eles podem somente não agregar valor. O caso grave é o site, de fato, receber uma punição por receber tantos links de baixa qualidade.

Relacionamento de Conteúdos

Outro fator importante a se observar para se tirar proveito de um link, é o relacionamento entre os conteúdos “linkado” e “linkante”. As Search Engines não valorizam um link somente por texto âncora e relevância da página que faz o link. Elas analisam, também, a relação de conteúdos, ou seja, se ambas páginas tratam o mesmo assunto (futebol com link para outra página sobre futebol), o valor do link é maior do que se os conteúdos não são relacionados (futebol com link para página sobre carros).

Esta métrica tem sido amplamente utilizada no Google para dar maior relevância em buscas locais, fazendo com que pequenos websites de nichos específicos, possam alcançar bons rankings nas páginas de resultado.

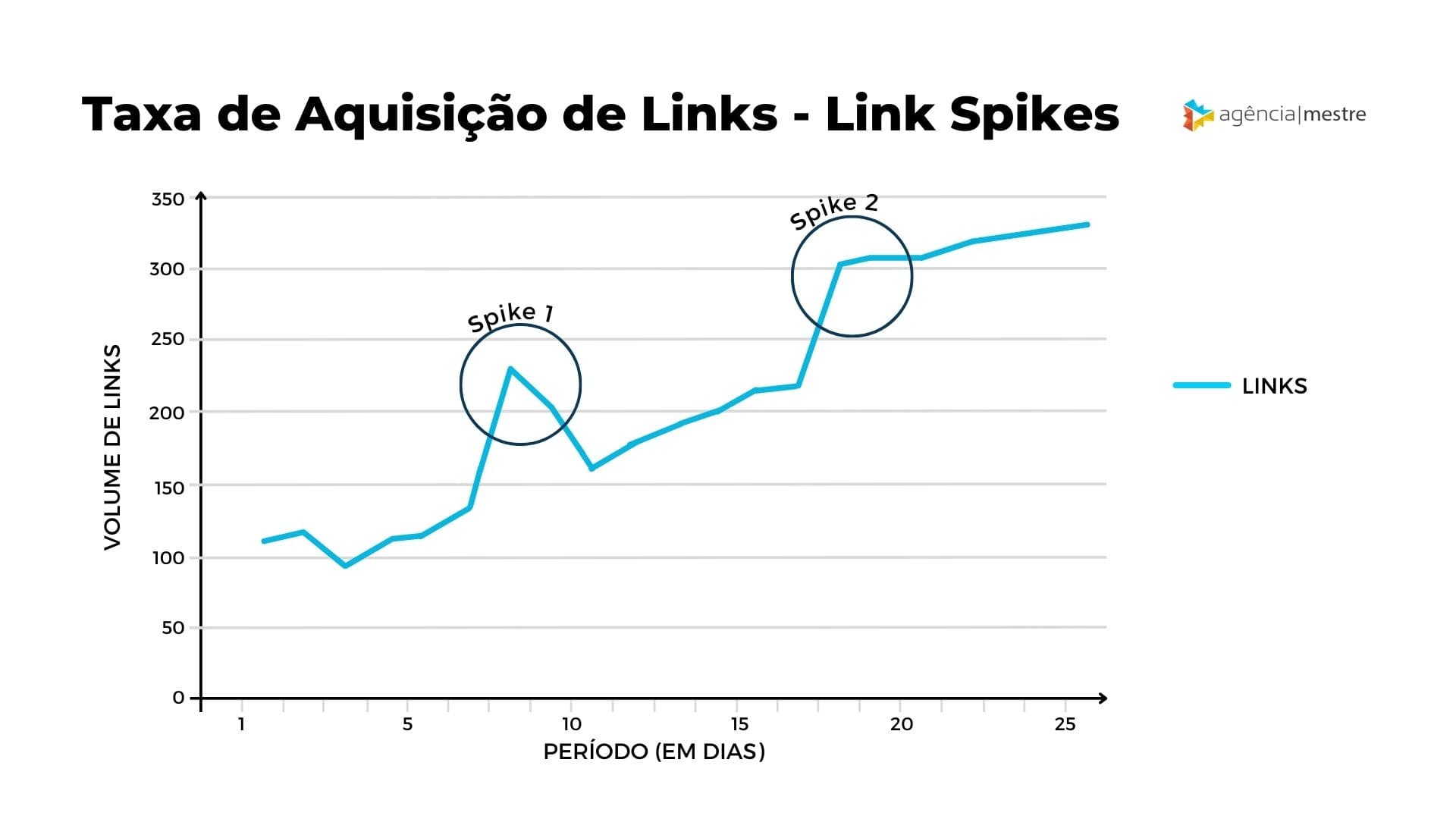

Taxa de Aquisição de Links

Uma métrica a ser observada pelos profissionais de SEO é a taxa de aquisição de novos links. Apesar de ser um bom objetivo ganhar links, não é um bom sinal ganhar muitos links de uma única vez, pois os Search Engines podem detectar isso facilmente e pensar que é algum tipo de manipulação.

Link Spikes

Se você monitora continuamente o número de links para o seu site e de seus concorrentes, vai perceber que às vezes ocorre um comportamento singular na curva de crescimento de links: grandes aumentos seguidos de quedas bruscas.

Esses “picos” na curva de crescimento de links são chamados de link spikes e o seu comportamento pode ser observado no gráfico abaixo:

Além de serem muito interessantes para acompanhar as tendências de pesquisas (os usuários só fazem links para aquilo que procuram / acham interessante), eles servem para indicar se um site pode ou não ser penalizado pelas Search Engines.

Antigamente, uma prática comum dos spammers era aumentar absurdamente a quantidade de links de entrada de um site, para que estes subissem na classificação. Com a melhora dos algoritmos das Search Engines, essas técnicas não surtem mais o efeito esperado – e são até punidas.

A criação súbita de muitos links para um site pode ser interpretada como uma tentativa de manipulação de resultados, ao invés do acúmulo natural de links sem qualquer interferência. Podendo ser motivo para levantar a bandeira para um determinado site, ou até mesmo puni-lo.

Obviamente que não é qualquer pico de links que vai acarretar em punições nas Search Engines. Vale ressaltar que existem vários tipos de link spikes – e é isso que vai determinar ou não uma punição.

Causas de Link Spikes

Os Link Spikes podem acontecer naturalmente ou não, e podem ter vários motivos. Sendo eles:

- Links Pagos

- Link Bait

- Comportamento

- Notícias

Os motivos que levam ao link spike é que são determinantes para dizer se foram, ou não, motivo para a punição de um site.

Vamos supor que um site não utiliza nenhuma rede social para divulgar suas páginas, serviços e conteúdo. Aumentos súbitos de links, sejam eles com âncoras perfeitas ou genéricas, podem estar denunciando uma compra descarada de links. Isso pode levar a uma punição.

O link bait também deve ser utilizado com cuidado. Ater-se ao foco do conteúdo do site é de extrema importância – o crescimento de links para o seu site vindos de sites que não tem conteúdo relacionado ao seu, não vão te acrescentar nenhum valor em termos de Pagerank.

Além do mais, as visitas vindas de links de assuntos não relacionados geralmente têm altas taxas de bounce.

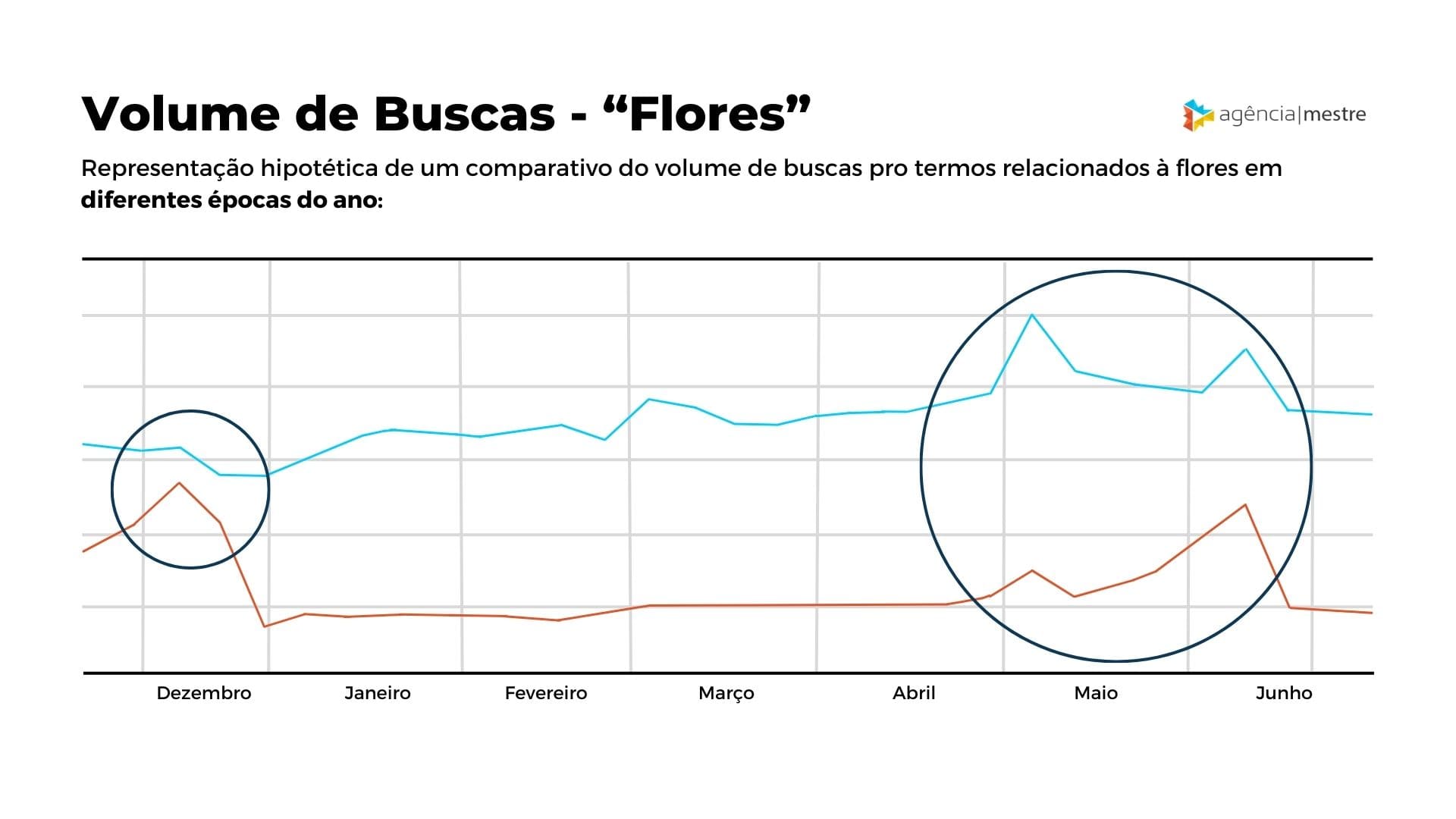

Os links gerados pelo próprio comportamento dos usuários não são motivo de preocupação. As pessoas só fazem links para aquilo que as chama a atenção ou se interessam – e isso pode acontecer de maneira sazonal ou não.

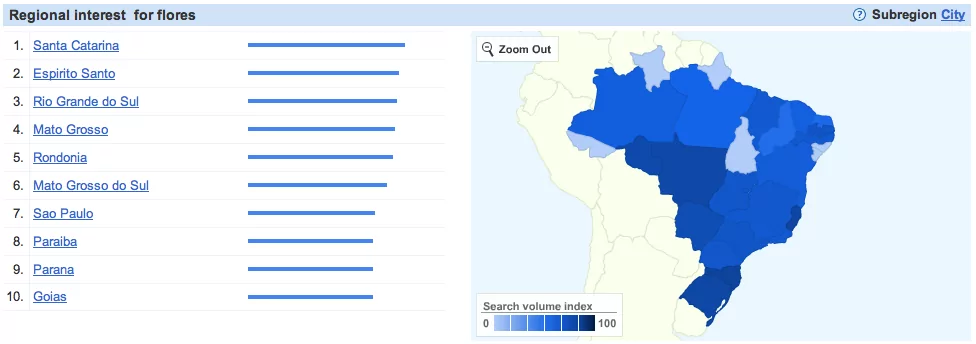

Por exemplo, vamos analisar as buscas por flores e presentes nos últimos 12 meses, no Brasil:

Em dezembro (natal) houve um grande aumento das pesquisas para presentes e um leve aumento para flores. Já em maio e junho (dia das mães e dia dos namorados, respectivamente), há picos maiores para as pesquisas por flores do que para presentes.

Se você tem um site sobre “flores”, em dezembro, maio e junho você provavelmente terá um aumento considerável de links para o seu site – o que provavelmente representará um link spike na sua curva de crescimento de links.

Por isso, monitorar a quantidade de Inbound Links do seu site / blog é de extrema importância para os seus trabalhos de SEO. Além de te fornecer informações sobre os efeitos de suas campanhas de link building, você também é capaz de verificar o comportamento geral dos usuários para determinadas pesquisas – que pode te auxiliar a melhorar as suas estratégias, desde o uso de keywords e a elaboração de conteúdo, até a procura por links externos.

Links Recíprocos

Um dos caminhos mais fáceis a se seguir para conseguir links é através de links recíprocos, ou troca de links, ou, em inglês, link exchange. Como sabemos, além da linkagem interna, receber links externos, ou seja, de outros domínios (sites/blogs), é importante para um bom posicionamento de sites nas buscas. Mas por que esse método é tão usado? Como funciona? E por que tomar cuidado com links recíprocos?

O que são Links Recíprocos?

Em inglês, são também chamados de reciprocal links, uma tradução exata do termo, links recíprocos consistem de um número de sites que se interligam ou um único site que troca links exclusivos com outros sites.

O processo para se formarem links recíprocos é muito simples: normalmente o webmaster de site ou blog entra em contato com outro e oferece um link para ele, pedindo em troca um linkback, um link para ele mesmo a partir do site ou blog deste outro webmaster.

Isso costuma funcionar muito bem. Como todos estão interessados em conseguir links, nada mais justo do que uma troca de links, assim, ninguém sai “mais favorecido” que o outro. Os dois ganham links e pronto.

Algum tempo atrás isso fez popularizar os Rings ou anéis/alianças de sites em que todos linkavam um para os outros, normalmente por meio de banners, gifs animados ou imagens que eram os logos desses sites. Ainda hoje, isso existe e muitos sites e blogs participam de esquemas assim.

Para os mais familiarizados com SEO, isso já acendeu o sinal de alerta, certo?

Cuidado com Links Recíprocos

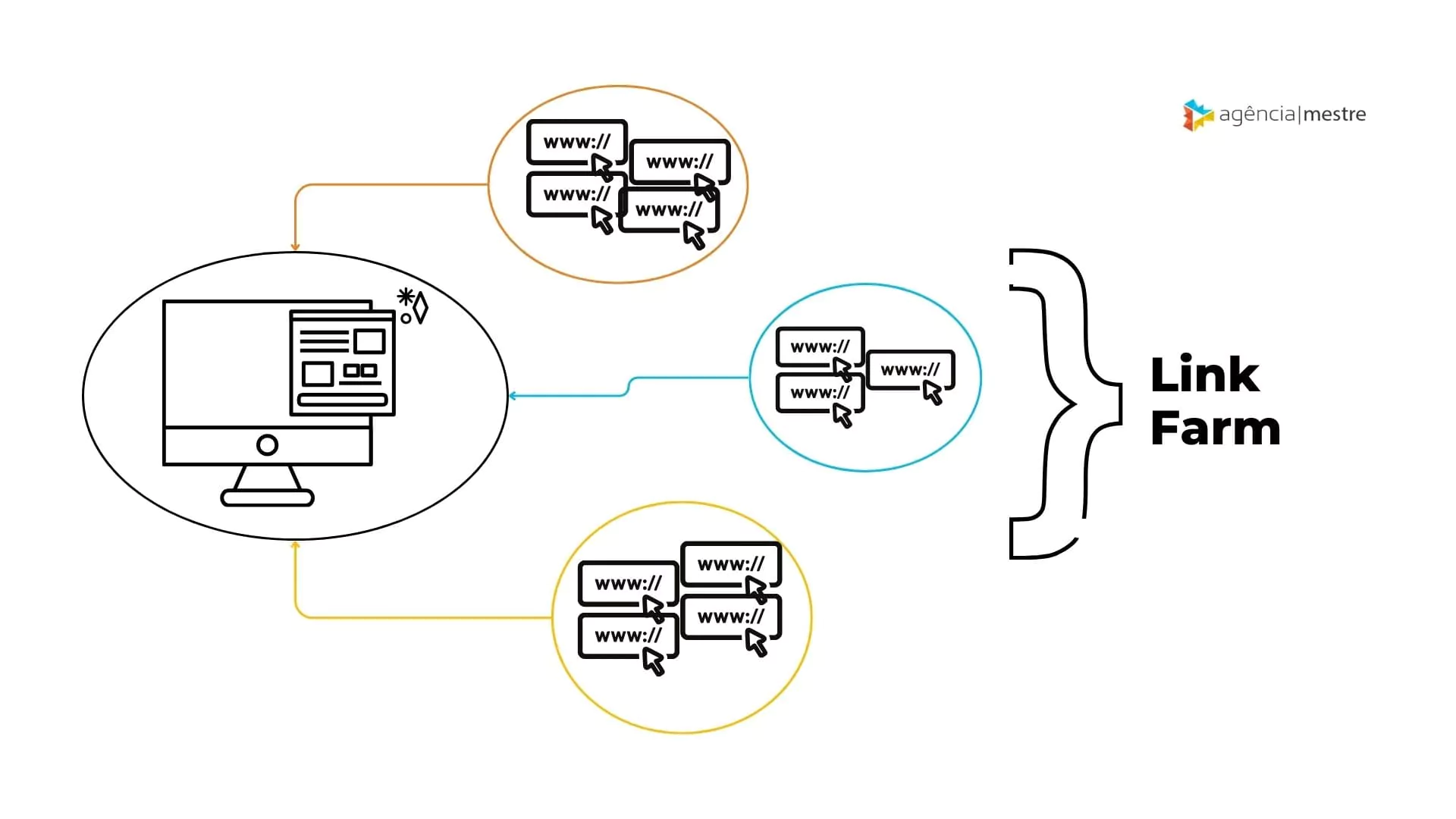

Para os menos familiarizados com técnicas de otimização de sites, o alerta é para o chamado link farm, “fazendas de links”.

Link farm define um conjunto de sites que linkam um para os outros ou um conjunto de sites que linkam todos para um só site, também chamados de doorway pages. O ponto importante a se observar: Link Farms são punidas pelo Google.

Pois bem, recentemente, o Matt Cutts fez uma enfatizada ressalva sobre “evite o uso de links recíprocos” na sua campanha de Link Building. O que para ele representou essa significativa mudança foi a adição do termo “em excesso”, ou excessivamente, ficando então “evite o uso de links recíprocos excessivamente” em sua campanha de Link Building. Isso faz toda a diferença.

Quer dizer então que o uso de links recíprocos para o Link Building do meu blog está liberado? Não! E sim.

O que está dito nas guidelines do Google é que é normal que aconteçam links recíprocos na Internet. Sem dúvida, procurando pelo diretório de sites do Google, será encontrado um link para o Yahoo! e, no diretório do Yahoo!, um link para o Google.

A questão é que são links relevantes, que vão realmente ajudar ou completar o processo de informação do visitante do site.

Valide seus Links Recíprocos

Ainda, o Matt Cutts avisa que um portfólio de links sobrecarregados de links recíprocos acende a luz de alerta no Google.

Basicamente, você tem sim o seu limite de links recíprocos: até uma certa quantidade você realmente está livre de punições. É aí que entra a parte de “evite o uso excessivo de links recíprocos”: investir todos seus esforços para conseguir links exclusivamente através da troca de links não será muito saudável.

Não é natural que todos (ou a maior parte de) seus links sejam recíprocos. Hoje em dia eu não vejo mais tantos sites envolvidos em alianças ou coisas do gênero, talvez realmente isso tenha perdido o seu valor. Alguns anos atrás isso era muito frequente.

A princípio, links recíprocos deveriam acontecer dentro do processo natural de descobertas na Internet, e não por pedidos e trocas objetivando ganhar um novo link. Um ponto muito interessante de se refletir quando é hora de decidir entre fazer ou não a troca de links é: Se não houvesse search engines e eu não precisasse de links para as search engines eu faria a troca de links?

Você deve se perguntar se o site para o qual você vai linkar realmente vai ajudar os seus visitantes, se você mesmo visitaria, e por consequência, recomendaria o site. Isso é um link: uma recomendação que você faz ao seu visitante.

Não é que os links recíprocos estejam liberados ou que sejam definitivamente proibidos. Mas se for fazer, tente focar a qualidade e a importância, para o visitante, de visitar tal site.

Número de Links em uma Página

Uma das perguntas mais discutida na área de SEO é quantos links devo possuir em uma página, ou melhor, qual o número máximo de links em uma página?

Esta pergunta sempre foi muito controversa, vários acreditavam em poucos links, outros diziam que muitos links não tinham problemas. Já na visão do Google, em suas Guidelines para Webmasters, o Google esclarece um ponto relevante sobre as linkagens nas suas páginas:

“Torne seus links rastreáveispara que o Google possa encontrar outras páginas do seu site por meio dos links da sua página.”

Historicamente, o Google recomendava até 100 links em uma página, visto que seus robôs indexavam apenas 100Kb de informações de uma página (e mais de 100 links poderiam facilmente superar esse número).

Com o tempo, essa informação se tornou obsoleta. Atualmente, o Google concentra-se, principalmente, na experiência do usuário. Isso significa que, independentemente de quantos links a sua página tenha, eles devem ser relevantes e agradáveis para o usuário.

É claro, que se você praticar técnicas de Black Hat você poderá ser punido, mas se você tiver 200, ou 300 links, e eles forem realmente relevantes aos usuários, não existe problema algum.

No entanto, um forte argumento para sustentar a ideia de poucos links é a questão do Link Juice: quanto mais links você tiver em sua página, mais você estará distribuindo seu Juice entre as páginas internas.

Talvez a melhor opção seja pensar em uma arquitetura interna mais organizada ou mais orientada a certas páginas.

Endereços IP

Cada website cria uma relação com o outro através de um link, conectando duas páginas (ou arquivos). Mas se olharmos como a internet funciona, veremos que cada conexão (link) é uma ligação entre servidores, bem parecido com a ideia do funcionamento da web.

E isso pode-se visualizar no momento em que você faz a conversão de um nome de um domínio(URL) em um IP, que nada mais é do que o endereço do servidor na web.

Assim como nós podemos ver o endereço de IP de cada website na internet, os Search Engines podem fazer o mesmo a fim de identificar quem é quem e assim analisar melhor como a web está relacionada. A partir disso, vários links entre páginas com IP classe C semelhantes e do mesmo dono podem ser interpretados como um esquema de troca de links no mesmo servidor, e logo podem ser desvalorizados. Mas para entender esta questão, é importante entender sobre classes e endereços IP.

Primeiro, um endereço IP é um número na forma NNN.NNN.NNN.NNN, 4 números separados por pontos que variam de 0 a 255, mas possuem algumas limitações de uso e especificações. Um exemplo de endereço IP: 64.233.161.104 (Google). Este número é o endereço real de www.google.com – a URL é como uma máscara para facilitar memorização.

O endereço IP é dividido em classes que servem para restringir o uso e cumprir alguns outros detalhes que não interessam no momento. Para este escopo, basta entender a formação do endereço IP e as 3 classes de IP: A , B e C – que dividem e organizam o IP da seguinte maneira:

- A.B.C.NNN

Voltando à afirmação em negrito, sites na mesma classe C são sites que ocupam a mesma faixa de endereços IP, por exemplo:

- 64.233.161.104

- 64.233.161.105

- 64.233.161.110

- 64.233.161.111

- …

Se uma Search Engine identifica que vários sites de uma mesma classe C estão trocando links entre si e ainda são do mesmo dono, ela passa a desvalorizar todo esse conjunto de links ou até mesmo pode penalizar os sites envolvidos. É como você falar de você mesmo (linkar para os próprios sites) – não diz muita coisa. E dependendo de o quanto você fala de si mesmo, pode acabar com a paciência de quem ouve (usuários / SEs). Em adendo, se você ainda tentar manipular isso para mascarar a propaganda própria e alguém descobrir, com certeza você perderá muitos créditos – a penalização por uma Search Engine.

Sendo assim, evite a troca de links que se configuram neste quadro, a punição pode demorar, mas não falha.

Técnicas de SEO: Link Building

Link Building é o conjunto de técnicas de SEO responsável pela arquitetura interna de links de um site e pela conquista de links externos, cujo resultado produz uma melhoria no posicionamento do website junto ao Google.

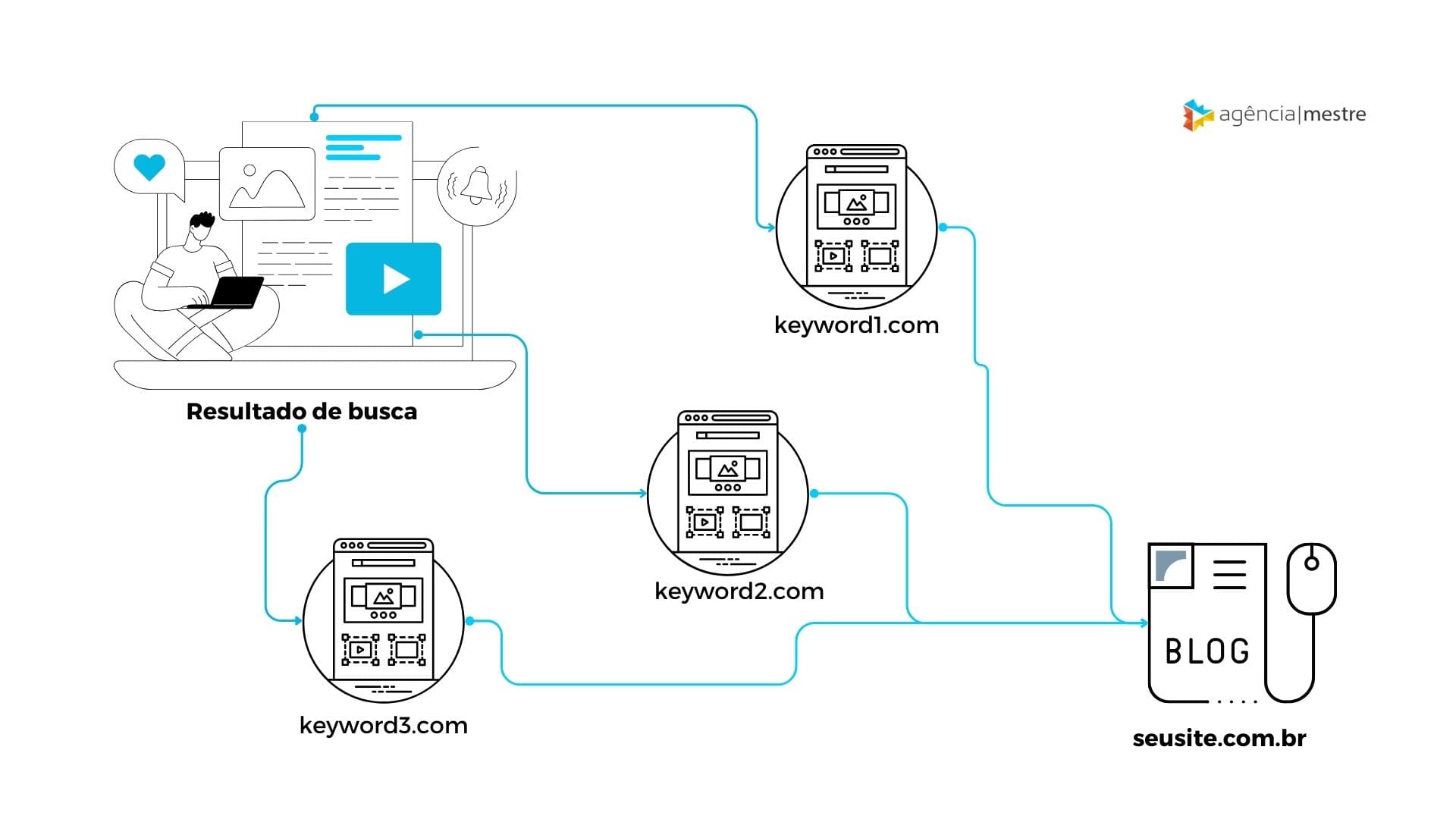

Como já explicamos, os links são a forma pela qual os principais buscadores navegam pela Internet, descobrindo novos sites e páginas, determinando uma ordem de prioridade (ranking) de acordo com uma série de fatores, sendo os links, um dos principais e mais fortes sinais.

Quando falamos de links, precisamos entender que eles produzem vários benefícios para um website, tais como:

- Links tornam o seu site mais visível os mecanismos de busca: Enquanto os robôs de busca navegam pela Internet, eles utilizam os links para descobrir novos caminhos. Eles indexam (lêem) uma determinada página, identificam os links presentes nesta página, navegam pelos os links que saem da mesma, indexam estas as novas páginas, navegam pelos links destas e assim por diante.

- Mecanismos de busca usam a quantidade e qualidade dos links apontados para uma página como determinante de importância da mesma: Quando muitos links de qualidade e relevância apontam para sua página, isso indica para o mecanismo de busca que a sua página é significativa e que o seu conteúdo é relevante.

- Links fornecem informação extra sobre a página para os quais apontam: As palavras-chave que aparecem nos links que apontam para o seu site muitas vezes são usadas pelos mecanismos de busca como informação adicional sobre o seu site. Quando muitos links referenciam o seu site com uma palavra específica, se essa palavra já não for uma palavra-chave que o seu site aparece bem nos resultados de busca, ela pode ser incorporada como uma.

- Links trazem robôs de busca para sua página, mas também trazem visitantes: Esta é uma das funções mais importantes dos links, já que no fundo o objetivo de se otimizar um site é atrair mais visitas./li>

Os objetivos de conseguir links com uma campanha de Link Building são, não só conseguir links para aumentar a sua autoridade (no Google, muitos mencionam como PageRank) e um melhor posicionamento do site nas buscas, como também conseguir aumentar as visitas do site.

A principal questão quando se fala em Link Building é: como ganhar links?

Link Building: Por Onde Começar?

Quando se inicia um trabalho de Link Building, o primeiro passo é entender as oportunidades fáceis e as difíceis. A mais fácil é arrumar a casa, ou seja, varrer todo o site, redescobrindo cada página existente e qual assunto deve ser tratado em cada página. Uma vez com esta arquitetura definida, você saberá quais as palavras-chave que cada página deve focar e, por consequência, o texto âncora que deve ser usado para linkar para cada página.

Assim que você tiver o conhecimento de cada página e cada palavra-chave que ela aborda, é hora de começar a parte mais fácil do trabalho de Link Building é um dos mais eficientes a curto prazo: a linkagem interna das páginas do seu site. É no próprio site que o Link Building começa.

Linkagem Interna

O desenvolvimento de links internos faz parte da técnica de Link Building, envolvendo diversos aspectos da própria estrutura do site. E para tal tarefa é necessário que se conheça o site, tão bem quanto a palma da mão.

Neste passo, você precisa identificar/entender:

- Os assuntos das suas páginas

- Garantir que elas recebam links

- Garantir que nenhum link esteja quebrado, ou seja, que aponte para uma página não existente

No primeiro ponto, conduza uma avaliação em seu software de Web Analytics (tal como o Google Analytics mesmo) e veja quais são as páginas que mais recebem visitas no seu website. Em seguida, analise quais palavras-chave que elas abordam e qual o posicionamento destas páginas no Google. Uma dica importante aqui é buscar esta palavra-chave no navegador anônimo, pois ele descarta boa parte da personalização que os mecanismos de busca tem hoje em dia.

De posse desta informação, crie uma tabela, relacionando uma palavra-chave com uma determinada página e ao encontrar uma destas palavras em um artigo ou conteúdo, sempre faça um link para a página escolhida.

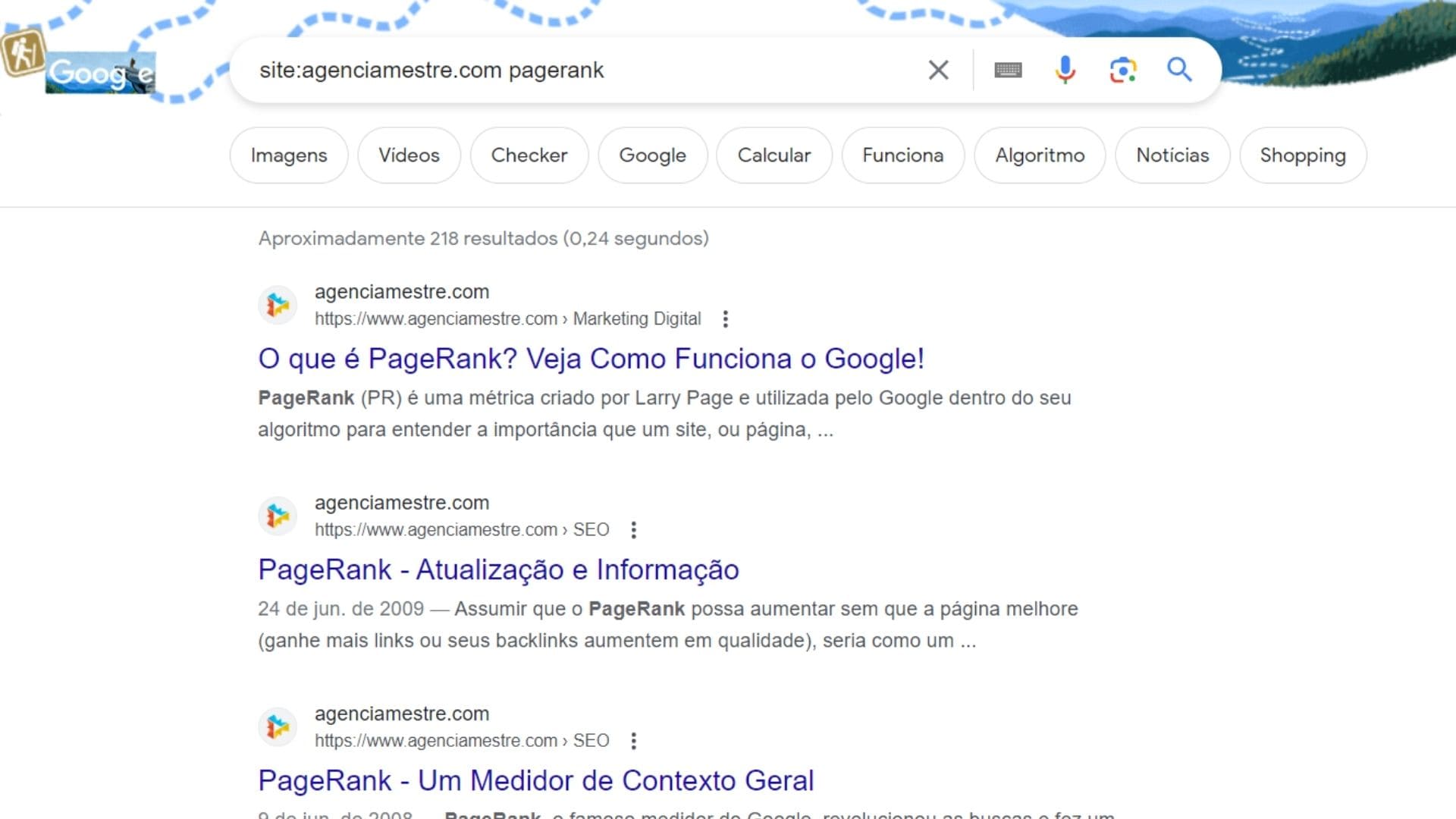

Vale lembrar que você não precisa criar um link em toda ocorrência da palavra dentro de um artigo, mas sim na primeira ocorrência desta palavra. Desta forma, a linkagem não fica redundante para o usuário.

Ao longo desse processo, você acaba descobrindo, e se necessário, re-estruturando a arquitetura de links do site, dando origem a novos links, conforme as páginas são re-escritas, e, de acordo com a qualidade da página que está linkando, é possível conseguir melhorar o posicionamento da página que está recebendo o link.

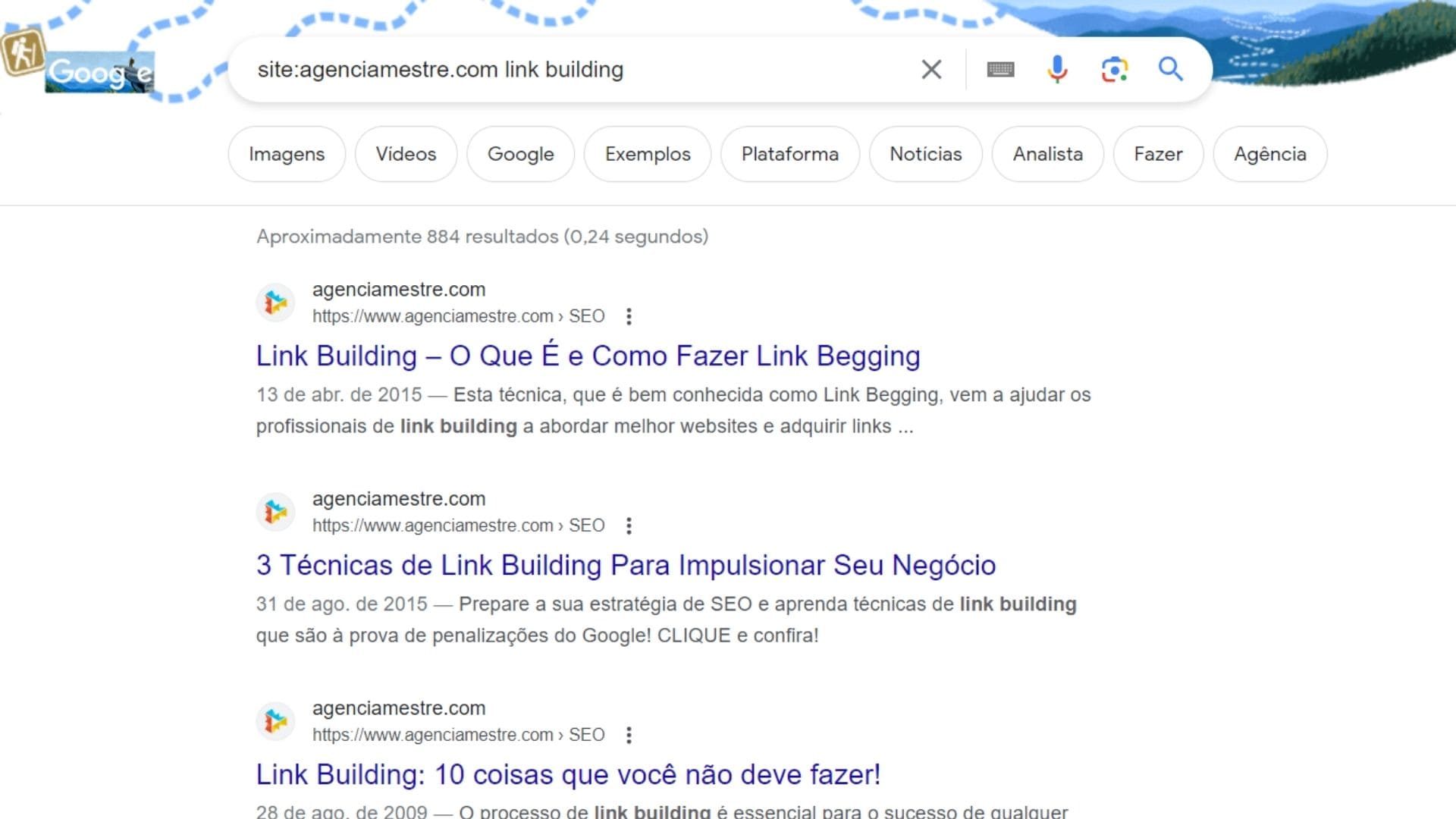

Uma dica muito relevante que sempre utilizo em meus projetos é o uso do operador “site:”. Quando estou construindo um novo artigo e percebo que há uma palavra-chave importante, faço o comando “site:meusite.com.br palavra-chave” diretamente no Google.

Este comando exibe quais são as páginas mais importantes sobre este assunto dentro do meu site, dessa forma, eu normalmente escolho a primeira página, pois é ela quem tem mais relevância.

Da mesma forma, você pode utilizar o operador “site:” para identificar lugares onde você pode criar links para este novo artigo. Por exemplo, seu meu novo artigo falar sobre link building, eu poderia colocar no Google o comando:

Com isto, eu teria uma série de artigos que mencionam a palavra “link building”. Eu acessava cada um dos 10 artigos listados na primeira página e, na menção do termo, eu criaria um link para este meu novo artigo. Desta forma, eu garanto um pouco de autoridade para esta nova página que acaba de ser criada.

Para sites muito grandes, demanda bastante tempo, mas com certeza vale a pena e é de resultado certo, pois existem muito mais páginas de onde conseguir links.

Semântica de Links

A forma com que você cria um link em uma página é muito importante, possuindo uma forte relação com a qualidade do Link Building. Para entender melhor como a semântica pode nos ajudar, vamos considerar os seguintes casos:

- Para ótimas dicas de SEO, confira https://www.agenciamestre.com.

- Para ótimas dicas de SEO clique aqui.

- Um site com ótimas dicas de SEO.

Qual a melhor opção de linkagem?

Para quem já tem conhecimentos em SEO, rapidamente conclui que os exemplos 1 e 3 são melhores que o segundo exemplo. O exemplo número dois fornece um link, o que é bom, mas não agrega ao link nenhum valor semântico, pois a Agência Mestre (agenciamestre.com) não é uma referência para “clique aqui”. Se “clique aqui” fosse usado em uma busca, com certeza a agenciamestre.com não apareceria nas primeiras posições.

O exemplo 1 contém o nome agenciamestre, que é o próprio nome do domínio, mas se alguém procurar por agenciamestre rapidamente vai encontrar o nosso site.

Outra coisa importante a se notar é que uma URL informativa, porém concisa, ajuda para a relevância que o robô de busca agrega a uma página, ou seja: se um post tiver a URL www.agenciamestre.com/posts.php?id=12 , ele não terá nenhum valor semântico para o conteúdo do post. Você consegue supor o assunto de tal post?

Por outro lado, utilizar www.agenciamestre.com/seo/o-que-e-seo torna-se muito mais informativo e relevante, agora é possível supor do que o post trata.

Finalmente, o exemplo 3 é sem dúvidas a melhor linkagem. Da forma que está escrito, ele fornece o link e, principalmente, campo semântico para o conteúdo daquele link. Quando o buscador chegar a esta âncora linkando para www.agenciamestre.com e ainda com o texto “dicas de SEO”, ele vai entender que o site é referência para dicas de SEO.

Links Externos ou Backlinks

Uma vez que você tenha organizado a sua casa, você pode começar a pensar em ganhar links de outros domínios. A principal regra a você se lembrar aqui é que, sempre que você “plantar”, “trocar” ou “ser o responsável” pela criação de um link externo, você provavelmente estará violando uma das principais diretrizes do Google.

Conquistar links de forma editorial ou seja, natural, é uma das tarefas mais difíceis quando falamos de um projeto de SEO. Para esta tarefa, você pode utilizar três meios principais:

- Analisar links já existentes

- Criar conteúdo que atraia links

- Utilizar assessoria de imprensa para impulsionar estes conteúdos

Analisar links já existentes

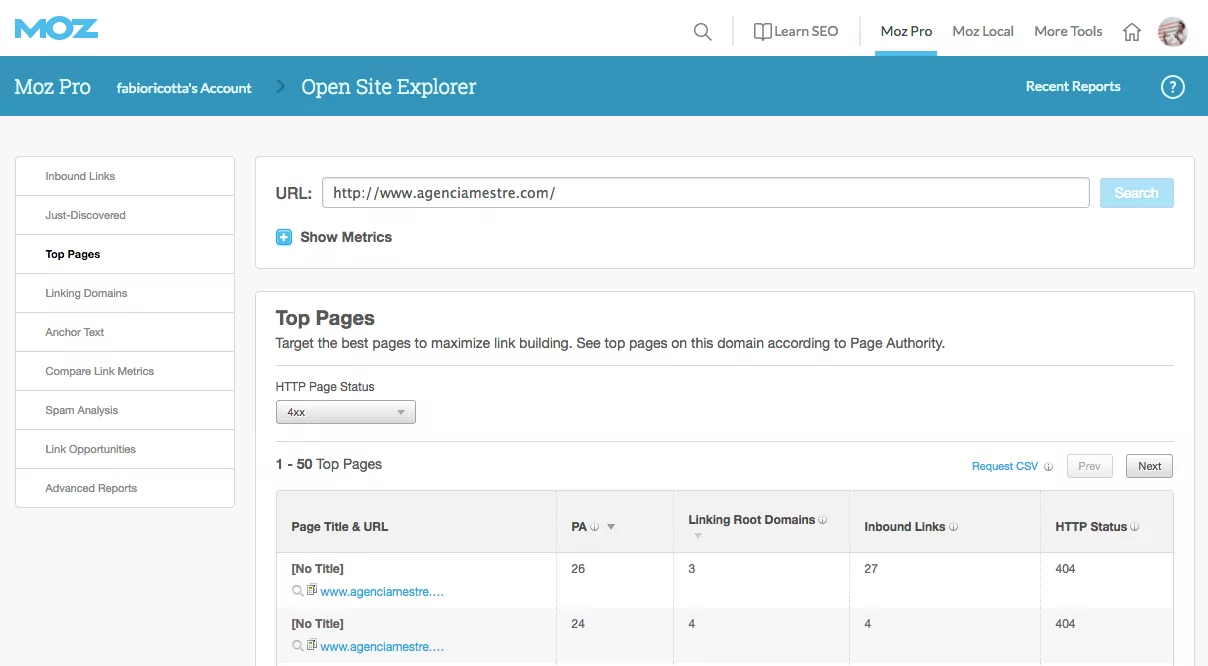

A melhor forma de trabalhar em um projeto de SEO é observar os links que já foram apontados para aquele projeto. Para isto, utilizamos algumas ferramentas, tais como Moz, Ahrefs ou MajesticSEO. Estas ferramentas têm o poder de analisar os links apontados para o seu site (backlinks) e nos dizer se algum aponta para uma página não existente, ou seja, que retorne erro 404.

Como é possível ver na imagem, existem páginas do meu site, que retornam erro 404 e ao mesmo tempo possuem links para ela. Um trabalho bem simples e rápido é criar um redirecionamento 301 de cada uma destas páginas para uma página que exista e tenha o mesmo assunto ou o mais relacionado possível.

Fazendo esta otimização em seu site, você conseguirá aumentar a autoridade que já estava presente e você não estava utilizando.

Como é possível ver na imagem, existem páginas do meu site, que retornam erro 404 e ao mesmo tempo possuem links para ela. Um trabalho bem simples e rápido é criar um redirecionamento 301 de cada uma destas páginas para uma página que exista e tenha o mesmo assunto ou o mais relacionado possível.

Fazendo esta otimização em seu site, você conseguirá aumentar a autoridade que já estava presente e você não estava utilizando.

Criar conteúdo que atraia links

Uma das formas de impulsionar o ganho de links é através do marketing de conteúdo, ou seja, da criação de conteúdos que realmente fazem a diferença para o seu público. No começo da era do SEO, chamávamos esta estratégia de linkbait, ou seja, criar conteúdos que fossem iscas para links.

Técnicas de Linkbait

Linkbait é uma das técnicas mais importantes para se ganhar links. Como o nome sugere, é uma isca para links – um conteúdo (vídeo, texto, conjunto de imagens, documentos, widgets, etc.) que mexe com as pessoas e, por seu engajamento, acabam gerando links. Em especial, através de um linkbait, é possível ganhar muitos links em pouco tempo sem que seja uma violação das diretrizes do Google. Vejamos alguns modos de linkbait:

Link Bait de Informação

Informação útil tem uma alta probabilidade de receber links, logo, a produção de informação única e de qualidade se torna um linkbait. Por exemplo: um arquivo tutorial de como configurar um servidor web é uma linkbait de informação. Um usuário irá ler o artigo um dia que irá ajudá-lo, e então ele poderá postar o link indicando que ele foi útil. Além disso, usar palavras chaves como “top 10“, “tutorial” e “dicas” é uma forma usada há muito tempo e até hoje funciona bem para títulos voltados para linkbait.

Outro formato também o uso ou criação de estudos/pesquisas. Quando você produz esta informação, muitos jornais e revistas online especializados provavelmente vão pegar esta informação e compartilhar com toda a sua audiência. Este para mim, é um dos modelos mais fortes de linkbait que existem.

Neste ponto, o fator atualização é fundamental – um site deve estar sempre atualizado.

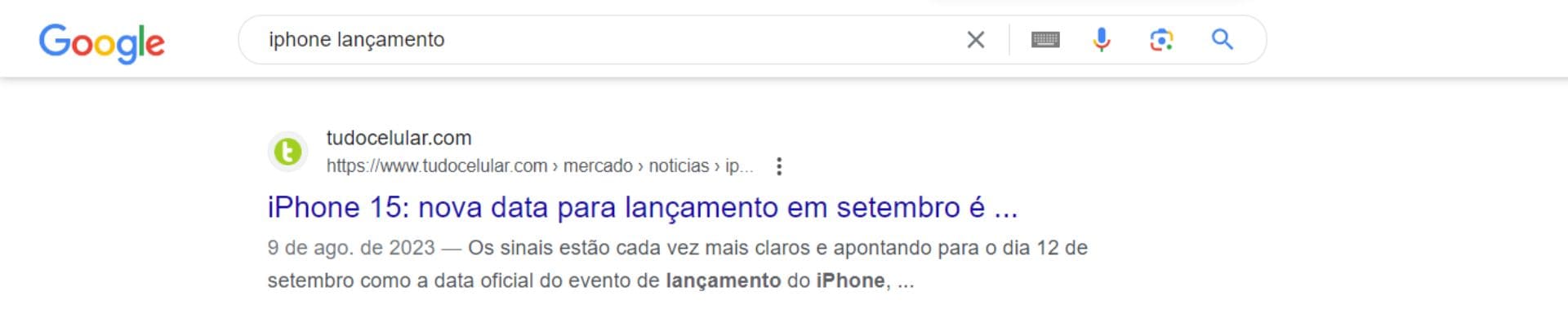

Link Bait de Novidades

Ser o primeiro site a reportar uma novidade pertinente irá tipicamente dar ao seu site um status de fonte de novidades. Então, assim que você vir alguma coisa nova e interessante, coloque no seu blog ou site. Postar com opiniões diferentes e atualizadas tem um valor ainda maior do que simplesmente divulgar a novidade.

Link Bait de Humor

Pessoas adoram rir, e o conteúdo de humor é bem viral por natureza. Aqui vale entender como a sua marca lida com humor e se é algo comum. Por exemplo, não é um modelo tão natural para um escritório de advocacia, mas já para uma marca que lida com barba masculina, pode ser algo bem diferenciado.

Um exemplo pegando o último caso, de barba masculina, poderia ser uma lista (top 10) das barbas mais curiosas do mundo. Ou ainda, pegar um vídeo de um homem puxando um caminhão com a sua barba. Isto estaria muito alinhado ao modelo de linkbait de humor.

Link Bait por Controvérsia

Citar coisas polêmicas é arriscado, mas pode gerar atenção e tráfego. Geralmente ocorre com questões políticas, sociais, raciais e sobre gosto musical. Infelizmente, as pessoas adoram discordar umas das outras. Se você publicar algo polêmico, é alta a chance de alguém comentar em algum blog/site e fazer o link para o seu site para citar o exemplo. Mas é necessário cuidado: um linkbait polêmico e controverso pode derrubar a reputação do site ou blog que publicou tal conteúdo. É necessário inteligência e bom senso antes de tudo.

Esta é uma das estratégias que eu menos gosto de usar, mas é o que faz o sucesso de empresas que falam de investimento, por exemplo, criticando pontos da política nacional.

Link Baits de Pessoas Famosas

Pessoas procuram muito por atores, bandas, etc. Fazer um artigo interessante sobre eles (como descrição de vida pessoal) é algo muito interessante quando se tem um assunto ainda não tratado, principalmente para os fanáticos.

Quando aquela pessoa famosa ou grupo, está surgindo qualquer conteúdo pode fazer diferença. Contudo, se já for algo consolidado, você precisaria criar um conteúdo diferenciado, seja ele com uma informação nova ou com uma compilação de dados diferenciada.

Um exemplo de compilação de dados, foi o vídeo criado sobre Game of Thrones, quando estávamos próximo do lançamento da temporada 6. Foi criado um vídeo resumindo todas as 5 temporadas anteriores e assim conseguiram muita atenção:

Utilizar assessoria de imprensa

Uma vez que você tenha um conteúdo diferenciado, você pode contar com apoio de especialistas para divulgá-los. O uso de assessoria de imprensa é uma arma não tão explorada pelo ponto de vista de ganho de links, mas sim pela divulgação de simples releases.

Quando trabalhamos próximos de uma equipe de assessoria de imprensa, nosso foco é fazê-los conectarem nossos conteúdos diferenciados a jornalistas que possam usá-lo como fonte.

Um outro modelo também é realizar estudos e pesquisas, dando prioridade para algum veículo publicar. Este é o mais aceito pelos jornais e revistas online. Como eles entendem o valor de um linkbait informacional, sabem que ao publicar uma matéria com dados novos, irão atrair a audiência. Assim, utilize-se deste poder.

Por fim, estar próximo da assessoria de imprensa pode te levar ao status de fonte técnica de um assunto. Por um tempo dei entrevistas para diversos jornais quando falávamos de Internet, Marketing Digital e assuntos relacionados, pois a nossa assessoria de imprensa reforçava sempre que eu era um super especialista no assunto.

O que acontecia é que eu era convidado para dar minha opinião, os jornalistas gostavam e sempre retornavam quando tinham uma nova matéria.

Link Building: Precauções

Quando trabalhamos com uma campanha ou projeto de Link Building precisamos entender que dependendo do processo usado, podemos acabar caindo em alguma técnica que viole as diretrizes do Google, fazendo assim com que todo o nosso esforço seja perdido.

A principal forma de violação das diretrizes é através da chamada Link Farm, uma técnica de Black Hat, que consiste em criar ou utilizar um grupo de sites e páginas que você mesmo controla para indicar através de links um site específico que também seja seu. Na vida real praticamente é como se você tivesse “clones” que ficariam divulgando você mesmo para outras pessoas. Seria um pouco estranho não?

Este tipo de técnica onde vários sites seus se linkam, com o objetivo exclusivo de manipular o Google pode resultar em uma penalização completa destes sites junto ao Google. Contudo, um ponto importante é que isso não significa que criar links para outros sites seja proibido, muito pelo contrário, deve ser feito, é assim que funciona a Internet, ela precisa destes links.

A versão menor do Link Farm também deve ser evitada, ou seja, o cross-linking entre 2 sites que sejam seus. Na melhor das hipóteses, o Google vai ignorar todos esses links, na pior, vai penalizar os dois sites. Por isto sempre recomendamos, melhor não arriscar.

É importante ainda usar o Link Building para promover todo o site, e não exclusivamente uma página. Promovendo todo o site, novos links vão surgir por todo o site, distribuindo toda a autoridade entre estas páginas. Quando se promove uma única página, todos os links novos normalmente seguem para esta mesma página, fazendo com que a autoridade se concentre em uma porção pequena do seu site, e assim o Google pode não olhar para isso com bons olhos, entendendo que talvez esta seja uma tentativa de manipulação dos resultados e punir esta página que está sendo promovida.

Isso também está conectado diretamente com dois outros pontos que devem ser evitados: sempre o mesmo texto âncora no link para uma determinada página e o mesmo texto ao redor do link. Esses dois pontos juntos podem caracterizar links “manipulados” e o Google poderá conduzir a uma penalização ou irá filtrar estas páginas dos seus resultados de busca.

Como eu já mencionei acima, sempre que você “plantar”, “trocar” ou “ser o responsável” pela criação de um link externo, você provavelmente estará violando uma das principais diretrizes do Google.

Então fique atento para não cair em uma destas penalizações possíveis frente a uma ação já detalhada pelo Google.

O que é Black Hat SEO?: Técnicas de SEO para você evitar

Black Hat SEO é o termo utilizado para caracterizar técnicas de SEO consideradas “ilícitas” ou abusivas, ou seja, técnicas que aproveitam uma possível brecha nos algoritmos de classificação de resultados ou exageram o uso de alguma técnica White Hat SEO. Em oposição, o White Hat SEO é composto por técnicas de SEO consideradas válidas por search engines.

Uma curiosidade: O uso dos termos white hat (chapéu branco) e black hat (chapéu preto) deriva de filmes Western (Velho-Oeste), onde o mocinho do filme sempre usava um chapéu branco, e o vilão, um chapéu preto.

Histórico Black Hat

O termo black hat SEO começou a ficar popular em 2004, mas foi ao longo de 2006 que a busca por este tipo de informação realmente aumentou. Outra curiosidade: no mundo todo, o local onde mais se busca por Black Hat SEO, é a Índia. Em um segundo lugar muito distante, aparece o Reino Unido, seguido de perto pelos EUA.

Técnicas de SEO: Black Hat

Antes de partir para técnicas Black Hat, tenha em mente que a razão pela qual você deve conhecer estas técnicas é para que não as utilize por acidente, muito menos intencionalmente, pois, como mencionado anteriormente, elas são práticas não recomendadas por search engines.

Para cada técnica de White Hat SEO, quase sempre, existe uma versão black hat dela. As mais conhecidas são:

- Keyword stuffing

- Texto escondido

- Links escondidos

- Doorway pages

- Cloaked pages

- Link farming

- Spam em comentários de blog

- Comprar links

- Troca de links

Keyword Stuffing

Basicamente, Keyword Stuffing é o uso excessivo de keywords em seu conteúdo, ou seja, você faz uma página sobre notebook e escreve a palavra para todo lado. O título fica “Notebook, notebooks, venda notebook, notebook hp, …”; bem como toda porção da página fica com cara de spam de tanto que se repete a palavra.

Isso é um abuso de uma técnica white hat, ou seja, fazer com que sua keyword principal apareça pela página, mas sem abusar.

Texto Escondido

Texto escondido é justamente o que o nome diz: o webmaster procura uma maneira de esconder o texto da visão do visitante, seja por sobreposição de camadas (divs) através do uso de CSS ou simplesmente usando a propriedade display none, também do CSS, para que o texto não apareça.

O objetivo é esconder texto com alta densidade de keywords (texto utilizando a técnica de Keyword Stuffing) para que o visitante não veja o texto mal produzido, mas que a search engine encontre o texto e coloque o site algumas posições adiante, já que tem tantas menções de uma determinada keyword.

Mesmo que não seja utilizado keyword stuffing, se o texto for identificado como puramente para search engines e manipulação de seus rankings, a técnica é considerada black hat.

Links Escondidos