{+}

Quando em conversa com profissionais da área ou até mesmo clientes, sobre métricas a se acompanhar para um site, em um momento ou outro a questão sobre o volume de páginas indexadas do site sempre entra em cena. Tipicamente, todos tem o conhecimento geral sobre o comando site:, basta apenas ser um pouco curioso sobre a área que facilmente encontramos uma pessoa com esse conhecimento.

A idéia da métrica, “quantas páginas do meu site a Search Engine conhece?”, é interessante, mas é pouco explorada normalmente, mesmo por aqueles que tem o conhecimento do comando site:, que apresenta algumas características peculiares, como a falta de consistência aparente nos dados.

Volume de Páginas Indexadas – site:meusite.com.br

A verdade é que o comando site: somente retorna a quantidade exata de páginas indexadas quando esta quantidade é um número pequeno, menor do que 50. Em um teste simples, utilizei o meu site, frankmarcel.com, e para a busca inicial foram estimadas 85 páginas indexadas, já com a indicação do “Aproximadamente”:

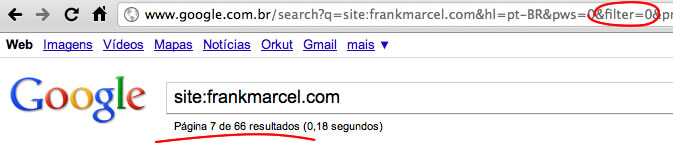

Porém, navegando página a página, mesmo sem o flitro de conteúdo duplicado (ou seja, estavam sendo exibidos resultados considerados similares a outras páginas do site), o total de 85 páginas caiu para 66 – 22% menos páginas indexadas:

Isso leva naturalmente a consideração sobre o valor desta diferença, se seria constante ou sempre próximo de um valor. O que eu vi em meus testes é que não. Diferentes tamanhos de sites acabam por provocar diferentes tamanhos de variação. Quanto maior o site também, mais difícil fica medir esta quantidade. Quanto mais páginas, maior a chance de um alto “erro” no valor aproximado de páginas indexadas e o valor encontrado ao se navegar até a última página de resultados de busca.

Para sites com menos de 100 páginas, uma forma rápida de se chegar ao valor final é adicionar o parâmetro &num=100 na URL da busca. Isso requisita ao Google que sejam mostrados 100 resultados por página, fazendo com que ele acerte o número de páginas rapidamente.

Outro detalhe interessante sobre o uso do site: é fazer a busca específica sobre subdiretórios:

site:meusite.com.br/subdiretorio/

Essa consulta traz valores específicos de páginas indexadas para o subdiretório definido. Curiosamente, muitas vezes o valor de páginas indexadas para um subdiretório frequentemente é maior do que o número de páginas de todo o site. De fato, não faz sentido, mas mostra um caminho alternativo e mais inteligente para se verificar volume de páginas indexadas: a segmentação.

Se um site possui 5 categorias, cada uma com 100 páginas, mais importante do que saber se o site possui 329, 423 ou 298 páginas indexadas, é saber de cada categoria: 89, 50, 72, …, pois assim é possível identificar qual categoria tem melhor e pior desempenho e definir o plano de ação que tenha resultado de maior impacto geral de visitas, conversões e rankings para o site.

Essa mesma lógica vale para subdiretório de subdiretório (/subdiretorio1/subdiretorio2/) e até para identificar conteúdo indexado sobre uma determinada keyword:

site:meusite.com.br keyword

A busca acima retorna os resultados do site relevantes para a keyword utilizada. A dica principal é checar os links internos entre páginas que circulam sobre o mesmo tema para garantir uma boa troca de link juice entre elas, em especial, identificar a página mais importante para aquela keyword e garantir um link de todas as outras páginas para ela.

Sitemap.XML – Volume de Páginas no Índice

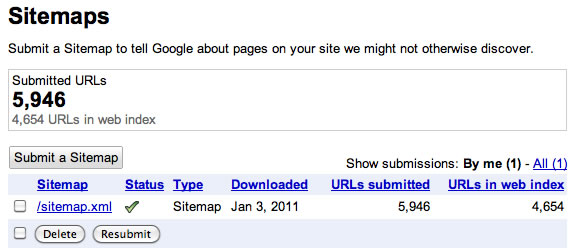

Hoje em dia, a validade do Sitemap.XML e seu envio a Search Engines está mais difundida e muitos websites já tem o seu sitemap criado. E, considerando informações oferecidas pelo Google, o Sitemap.XML também serve como referência para o Google apresentar um valor de URLs de um website presentes em seu índice direto do Google Webmasters Tools, na seção de sitemaps XML:

O destaque por aqui é que raramente o resultado aproximado ou exato da busca site: é igual ao número apresentado no Google Webmaters Tool nesta seção de sitemaps. Eu pelo menos nunca vi um valor igual considerando um volume de páginas maior do que 100.

Mais uma vez, faz-se útil a segmentação do site, desta vez, em diversos sitemaps XML, um por categoria/subdiretório, para se conseguir outra vez o quadro de indexação do site por blocos. Este processo torna possível a identificação/confirmação de categorias com melhor ou pior indexação, o que serve de orientação para desenvolvimento da otimização do site.

Sitemap.XML e Comando site: Segmentados

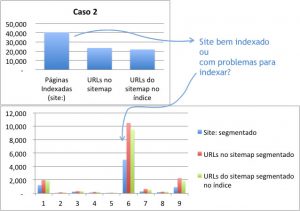

O grande valor da análise mais próxima e da segmentação dos dados é que ela acaba abrindo os olhos, ou orientando melhor sobre onde pode haver problema ou não. Para ilustrar, levantei alguns casos diferentes os quais já encontrei.

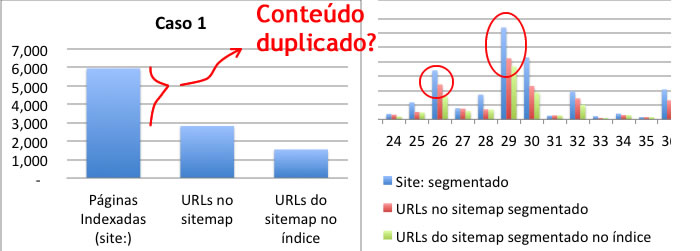

Na maioria das vezes, o volume de páginas apontadas no comando site: acaba sendo maior do que o volume de URLs em um sitemap. O Google muitas vezes pode acabar indexando muito mais conteúdo do que o que você determina que faça parte de um sitemap.xml (como resultados de busca), ou simplesmente erra nas contas quando precisa exibir um valor aproximado de páginas de um site.

A vantagem da segmentação é que você acaba isolando problemas a determinadas áreas do site:

Em uma visão geral, seria difícil imaginar onde estaria todo aquele conteúdo a mais indicado pela busca utilizando o comando site: comparado ao volume de URLs do sitemap; mas segmentando a busca e os sitemaps em diretórios, é possível idetificar qual área do site possivelmente apresenta problemas.

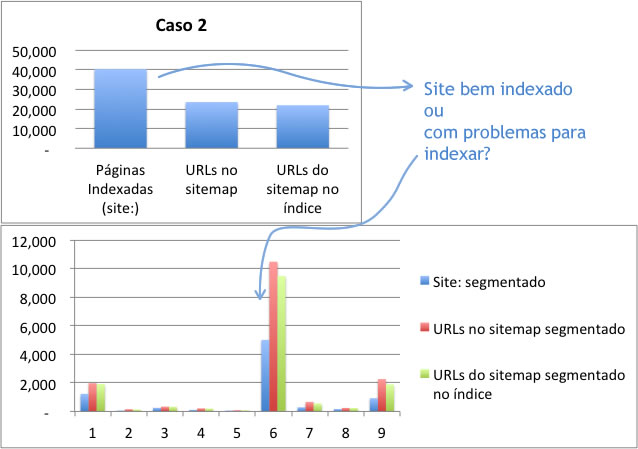

Um caso bem atípico que encontrei por aqui foi o comando geral por site: e a busca segmentada apresentarem dados muito distintos:

Ao passo que a busca site: em comparação com as URLs no Sitemap.XML apresentavam até um quadro comum e, apesar de o valor das URLs do Sitemap.XML no índice de resultados serem bem próximas do total de URLs do sitemap, quando executada a segmentação, um quadro de alerta se destacou: na verdade, por quase todo segmento do site, havia o dobro de URLs no Sitemap.XML do que era apresentado na busca segmentada com o comando site:, enquanto a quantidade de URLs no índice mantinha-se próximo do total de cada sitemap.

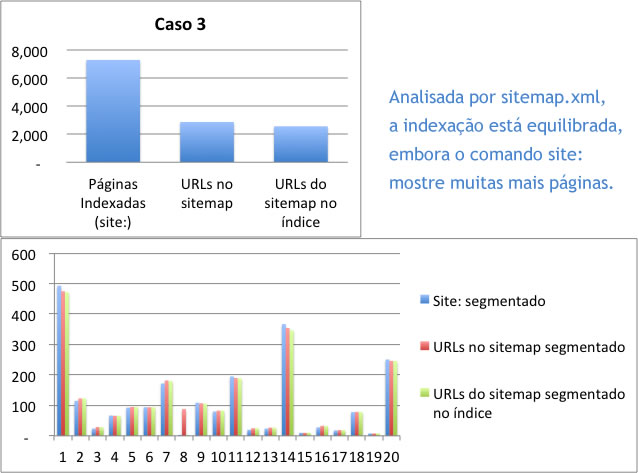

Um quadro mais idealizado seria próximo do que é visto na imagem a seguir:

Apesar da busca geral indicar uma disparidade, a segmentação mostra que há um equilíbrio, exceto pelo segmento 8. O quadro geral de URLs no Sitemap e URLs do Sitemap no índice de resultados também é bem próximo.

Como é difícil assegurar a precisão das informações apresentadas tanto no Google Webmasters Tools quanto na busca por páginas indexadas, estas análises são mais úteis para identificar os Oitos em websites, ou seja, identificar uma seção onde realmente exista um problema de indexação. Em outros casos, onde pode haver alguma incerteza, é conveniente olhar também a métrica a seguir.

Páginas com ao menos 1 visita de busca orgânica no GA

Saindo do Google Webmasters Tools, o Google Analytics possui uma maneira excelente de se saber uma informação melhor do que quantas páginas estão ou não no índice, mas quantas são realmente úteis: As páginas que recebem visitas de busca orgânica. Essa informação nós usamos diretamente no relatório de SEO que produzimos para nossos projetos, sendo o conceito mais interessante em todo este cenário.

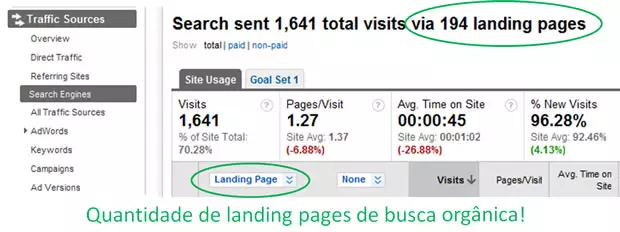

Para encontrar esta informação no Google Analytics, acesse a seção de Traffic Sources, escolha o tráfego por Search Engines e escolha “Google”. Na sequência, troque a exibição de Keyword para Landing Page e você poderá ver a quantidade de diferentes páginas que, de fato, recebem visitas oriundas no Google (lembre-se de filtrar por tráfego não pago, se for o caso):

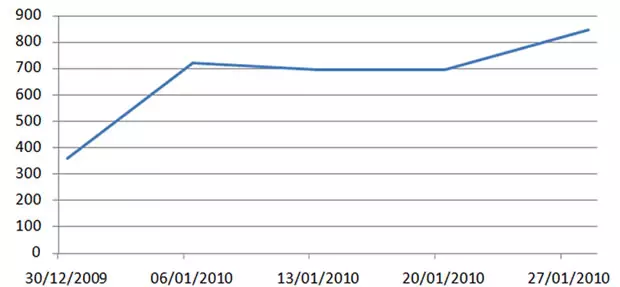

Faça o acompanhamento periódico deste número e entenda a evolução do seu site frente a Search Engines. Por exemplo, este acompanhamento permite entender como uma queda de páginas indexadas (comando site:) pode não afetar o tráfego do site, afinal, as páginas fora do índice poderiam ser páginas que não recebiam visitas. Mais páginas recebendo visitas é uma informação e um objetivo mais relevante do que mais páginas indexadas simplesmente.

Obviamente, o aumento de páginas recebendo visitas, em um cenário positivo, vai significar aumento de visitas também e, caso os dois não andem juntos, é um possível sinal de problema.

Por aqui também vale a segmentação para obtenção de dados refinados. Com a Segmentação Avançada no Google Analytics, chega-se a algo como ter um Google Analytics para cada seção do site configurada em um segmento e aí, é possível ver, de cada parte do site, como está a respectiva performance.

Pontos Gerais

Com toda essa análise em mãos, o quadro mais comum será ter mais páginas no site do que URLs indexadas no Google, mas o inverso pode acontecer. Pois é: mais páginas indexadas, do que páginas no site. Como é possível? Conteúdo duplicado. Claro que o Google não vai inventar URLs que não existem, na verdade, o webmaster é que terá a noção errada de quantas páginas o site possui por desconsiderar (ou desconhecer) problemas com conteúdo duplicado.

Identificado um problema deste tipo, todo o acompanhamento feito passa a ser ainda mais útil, pois a correção provavelmente levará a queda de páginas indexadas e/ou recebendo visitas, mas será possível rastrear o motivo e controlar melhor o desenrolar do quadro. E, o principal, a queda nos números não será um susto, será planejada e resultará em um melhor desempenho para o site.

Além de conteúdo duplicado, será possível identificar páginas que realmente estão sendo irrelevantes, por não receberem visitas, ou páginas que nem sequer estão indexadas, de onde você deve tomar a próxima ação – abandoná-las ou, preferivelmente, trabalhar com este conteúdo que já existe e fazer com ele seja mais um caminho entre a Search Engine e o seu website.